AI i security. Kiedy ludzkie zmysły to za mało

Coraz bardziej zaciera się granica między fizycznym bezpieczeństwem a cyberbezpieczeństwem. Każda nowa kamera wyposażona w algorytmy sztucznej inteligencji, każdy system dostępu funkcjonujący w chmurze, każda czujka połączona z centralą przez Internet stają się elementami Internetu rzeczy. To oznacza, że firmy, strzegąc swojego fizycznego bezpieczeństwa, muszą mieć baczenie na to, co się dzieje w ich cyfrowym otoczeniu.

Monika Żuber-Mamakis

Możliwości, jakie wiążą się z upowszechnieniem algorytmów sztucznej inteligencji, imponują. Ale nie bez przyczyny piszemy m.in. o zaletach zwykłych fizycznych kluczy (str. 38). Prostych i skutecznych, choć przecież nieidealnych i trochę, powiedzmy szczerze, archaicznych (dlatego w artykule opisujemy ich bardziej zaawansowane opcje). Z tych właśnie powodów są chętnie zastępowane wygodniejszymi rozwiązaniami. Może zachwycać możliwość udzielania zdalnego dostępu do pomieszczeń czy wygoda sterowania wszystkimi kluczami jednocześnie, ale trzeba pamiętać, że nie ma darmowych obiadków. Ta wygoda ma swoją cenę. Jest nią ryzyko ataku hakerskiego. Czasami celowanego w firmę lub grupę jej pracowników, typu spear phising, czasami wymierzonego wprost przeciwko konkretnej osobie, takiej, która w danej organizacji ma np. dostęp praktycznie do wszystkiego. To już tak zwany whaling, czyli polowanie na grubą rybę. Tylko od czujności i współpracy działów IT i menedżerów security zależy, czy będzie to polowanie udane.

Wyposażanie urządzeń security w algorytmy sztucznej inteligencji to oczywiście punkt dla graczy pozostających po dobrej stronie mocy. Sęk w tym, że moc AI odkryli także ci źli. Eksperci firmy Splunk należącej obecnie do CISCO, przygotowujący raport State of Security 2024. The Race to Harness AI zadali ankietowanym pytanie: Czy AI przechyli szalę na korzyść obrońców, czy atakujących? Respondenci byli podzieleni niemal równo: 45% przewiduje, że na AI najbardziej skorzystają napastnicy, a 43% uważa (bądź po prostu ma nadzieję), że AI pomoże atakowanym.

Na początek trochę danych

Rynek cyberbezpieczeństwa związany ze sztuczną inteligencją ma szansę na niemal sześciokrotny wzrost w ciągu najbliższych sześciu lat. Z obecnych 7,1 mld dol. w 2024 r. wartość ta ma wzrosnąć do 40,1 mld dol. w 2030 r. Oznacza to średni roczny wzrost na poziomie 33,4% – prognozuje firma MarketsandMarkets. Są tu uwzględniane zarówno narzędzia natywne generatywnej AI, takie jak wykrywanie zagrożeń i zapobieganie im, jak i rozwiązania cyberbezpieczeństwa przeznaczone do ochrony tejże AI, w tym ochrony wykorzystywanych przez nią danych.

Czym innym jednak jest generatywna AI, a czym innym algorytmy stosowane przez firmy branży security.

AI w security – mniej kreatywna, za to spostrzegawcza

Sztuczna inteligencja (artificial innteligence, AI) w obszarze bezpieczeństwa fizycznego obejmuje zastosowanie uczenia maszynowego (machine learning, ML) oraz głębokiego uczenia (deep learning, DL), które do pracy potrzebują danych pozyskiwanych z urządzeń, takich jak kamery, czujniki czy systemy dostępu. Na ich bazie algorytmy uczenia maszynowego pozwalają prognozować zdarzenia oraz optymalizować wydajność konkretnych zadań. Deep learning służy do wyszukiwania relacji między danymi wejściowymi a wyjściowymi, co pozwala na uzyskanie nowych informacji. Przykłady zastosowań tej technologii w zakresie bezpieczeństwa fizycznego obejmują rozpoznawanie obiektów, pojazdów i ludzi, a także generowanie alertów w przypadku naruszenia strefy zabezpieczonej. Uczenie maszynowe i głębokie uczenie są szczególnie skuteczne w przeszukiwaniu ogromnych ilości danych w celu identyfikacji wzorców i trendów, które mogą być trudne do zauważenia przez ludzi.

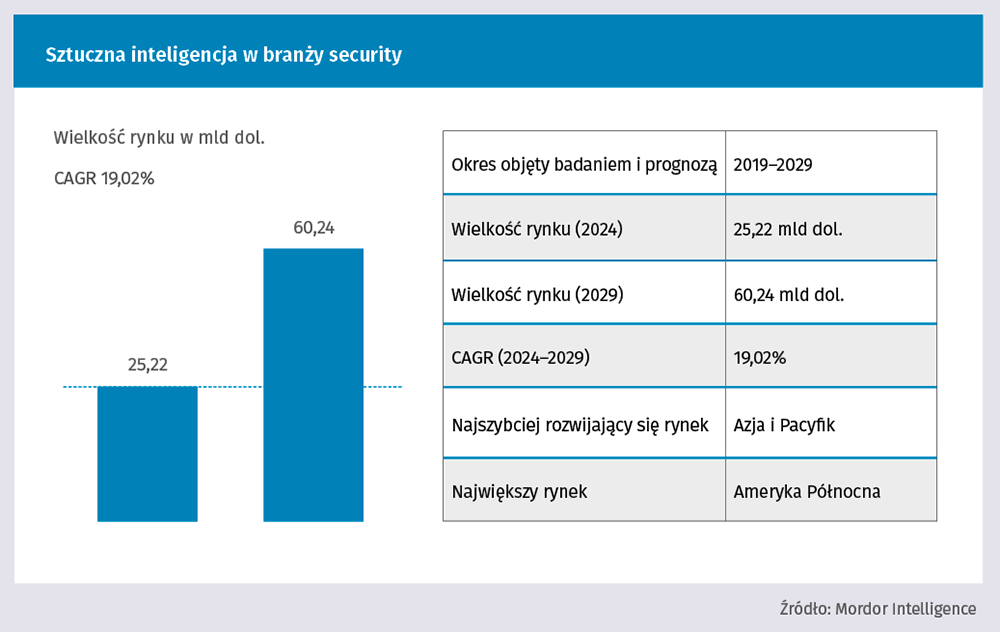

Ile w takim razie wart jest rynek algorytmów związanych z branżą security? O zebranie danych pokusiła się organizacja ekspertów Mordor Intelligence, specjalizująca się w mapowaniu złożonych systemów biznesowych. Według nich „wielkość rynku AI w sektorze bezpieczeństwa ma wzrosnąć z 21,19 mld dol. w 2023 r. do 50,61 mld dol. do 2028 r., przy CAGR na poziomie 19,02% w okresie prognozy (2023–2028)”. Natomiast zgodnie z raportem firmy analitycznej Fortune Business Insights globalny rozmiar rynku dostępu ma osiągnąć 25,22 mld dol. w 2027 r., przy rocznej stopie wzrostu CAGR wynoszącej 8,7%. W obu przypadkach mowa jest zatem o potężnych kwotach. Jest o co walczyć.

Po co branży security algorytmy AI?

Odpowiedź jest oczywista. W przypadku bezpieczeństwa fizycznego algorytmy AI przyniosły swoisty przełom. Trzeba przyznać, że nawet bardzo wyrafinowane urządzenia security napotykają barierę w postaci ograniczeń ludzkiej percepcji. AI tę barierę stanowczo przesuwa. Nie jesteśmy w stanie widzieć bardziej, słyszeć lepiej, mieć oczu dookoła głowy. A urządzenia security to potrafią, szczególnie jeśli dołoży się im oprogramowanie wykorzystujące uczenie maszynowe i deep learning. Dzięki nim ludzkie zmysły zyskują wsparcie, na jakie wcześniej nie mogliśmy liczyć.

AI umożliwia doskonalenie sposobów wykrywania zagrożeń, optymalizację systemów nadzoru i skuteczniejsze ograniczanie ryzyka. Wykorzystując zaawansowane algorytmy i możliwości uczenia maszynowego, AI przekształca sposób, w jaki chronione jest otoczenie fizyczne. To zaś oznacza transformację branży bezpieczeństwa fizycznego oraz tego, co może zaoferować swoim klientom. Wykorzystanie AI w systemach kontroli dostępu znacząco podnosi poziom bezpieczeństwa. Zaawansowane metody uwierzytelniania biometrycznego, takie jak rozpoznawanie twarzy czy skanowanie odcisków palców, znacznie utrudniają nieautoryzowany dostęp do obiektów. Zastosowanie algorytmów uczenia maszynowego powoduje, że wyposażone w nie systemy mogą uruchamiać alarmy lub informować personel ochrony o próbach włamania, co skutecznie zapobiega nieautoryzowanemu dostępowi oraz chroni poufne informacje i cenne zasoby. Inteligentne systemy kontroli dostępu mogą być integrowane z systemami zarządzania budynkami, co zapewnia kompleksowe podejście do bezpieczeństwa. Systemy te ponadto potrafią dostosowywać się do zachowań użytkowników, np. regulując oświetlenie i temperaturę w zależności od pory dnia oraz indywidualnych preferencji. To wszystko prawda. Tyle tylko, że za te możliwości pobierany jest haracz w postaci większego zagrożenia dla cyberbezpieczeństwa. Każde urządzenie podłączone do sieci staje się przecież potencjalnym back doorem. Furtką, przez którą może dostać się np. ransomware.

Licho nie śpi

Według raportu Veeam Data Protection Trends Report 2024 cyberataki są główną przyczyną przerw w działalności firm. Inne czynniki to awarie infrastruktury, sieci, pamięci masowej, oprogramowania aplikacji, zasobów chmurowych i serwerów, a także tradycyjne wypadki, katastrofy naturalne itp. W przypadku ataków ransomware każda organizacja powinna mieć świadomość, że tylko kwestią czasu jest to, kiedy za pomocą tego rodzaju złośliwego oprogramowania zostanie zaatakowana. Z danych opublikowanych we wspomnianym raporcie wynika, że 76% firm doświadczyło ataku przynajmniej raz w ciągu ostatnich 12 miesięcy. I choć jest to mniej niż w roku 2023, kiedy ataku doświadczyło 85% firm, to aż 26% z nich zostało zaatakowanych co najmniej cztery razy (!). A jedynie 13% firm stwierdziło, że skutecznie przeprowadza proces odzyskiwania danych w sytuacjach kryzysowych. Tylko 32% organizacji ma nadzieję, że na odzyskanie pełnej sprawności operacyjnej będzie potrzebować mniej więcej tydzień. A na pytanie o czas potrzebny na odzyskanie 50 serwerów 32% odpowiedziało, że zespoły IT mogłyby to zrobić w ciągu pięciu dni roboczych. Statystyki pokazują rosnącą przepaść między oczekiwaniami biznesowymi a możliwościami usług IT w zakresie ochrony danych.

Na granicy światów

Zacieranie się granic między bezpieczeństwem fizycznym a cyberbezpieczeństwem oznacza przenikanie do fizycznego świata zagrożeń płynących ze świata cyfrowego. Tymczasem według respondentów cytowanego już raportu Splunk zachowanie cyfrowego bezpieczeństwa staje się coraz trudniejsze. Aż 38% z nich wskazuje, że powodem tej trudności jest złożoność krajobrazu zagrożeń wynikająca m.in. z sytuacji geopolitycznej i związanej z nią wojny hybrydowej. Tymczasem w zastraszającym tempie rośnie ilość danych, w tym danych wrażliwych, które muszą być chronione. Nic więc dziwnego, że organizacje wkładają dużo wysiłku i pieniędzy w to, by dbając o bezpieczeństwo fizyczne, chronić dane, które generowane są przez urządzenia security. Algorytmy AI zdecydowanie poprawiają funkcjonowanie systemów security, ale same nie są odporne na zagrożenie. Są podatne na ataki, takie jak zanieczyszczenie danych czy nieautoryzowany dostęp do informacji wrażliwych.

Weźmy np. inteligentne kamery monitoringu wizyjnego wyposażone w algorytmy AI. Mogą one analizować ogromną ilość danych w czasie rzeczywistym. Potrafią także je interpretować, a co za tym idzie automatycznie identyfikować pracowników i gości, co zwiększa kontrolę dostępu do różnych stref budynku. Co jednak się stanie, gdy po ataku kamery przestaną rozpoznawać gości albo zmanipulowane wpuszczą osoby niepożądane? Realne jest też ryzyko naruszenia prywatności pracowników i klientów, gdyż technologie takie jak rozpoznawanie twarzy mogą być używane do monitorowania ludzi bez ich zgody. Podobnie biometria, mimo że oferuje wysoki poziom zabezpieczeń, nie jest wolna od ryzyka. Istnieją obawy dotyczące możliwości oszustwa (np. wykorzystanie fałszywych odcisków palców) oraz kradzieży danych.

Wykorzystanie sztucznej inteligencji w systemach zabezpieczeń fizycznych oznacza więc zarówno korzyści, jak i wyzwania. Z jednej strony poprawia efektywność monitorowania i kontroli dostępu, z drugiej – powoduje nowe zagrożenia związane z prywatnością i bezpieczeństwem danych. Bezpieczeństwo fizyczne i AI jak najbardziej mogą iść w parze, jeśli zostaną odpowiednio wdrożone. Jeśli jednak AI ma przynieść branży security wymierny zysk, to lepiej sięgać po ten miód małą łyżeczką, chochla się tu nie sprawdzi. ⦁