Optyka dla każdego. Cz. 4

Piotr Rogalewski

To już ostatni artykuł z cyklu „Optyka dla każdego”. Pora na opisanie budowy i klasyfikacji obiektywów, uzupełnienie informacji dotyczących rozdzielczości optycznej, wyjaśnienie działania migawki i ekspozycji oraz na krótkie podsumowanie.

MTF obiektywu

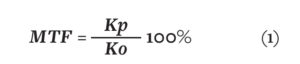

W poprzednim artykule poruszyłem kwestię rozdzielczości optycznej obiektywu. W uzupełnieniu tego zagadnienia postanowiłem omówić jeszcze jeden bardzo istotny parametr, który jest z rozdzielczością optyczną ściśle powiązany, a którego w opracowaniach dotyczących telewizji dozorowej szukać ze świecą. Chodzi o MTF obiektywu (Modulation Transfer Function), czyli w dosłownym tłumaczeniu funkcję przenoszenia (przekazywania) modulacji. Pomimo złożonej nazwy znaczenie tego parametru stosunkowo łatwo wyjaśnić. Otóż MTF określa procentową zmianę kontrastu po przejściu obrazu przez obiektyw w stosunku do obrazu oryginalnego przed obiektywem [1] i wyraża się wzorem:

gdzie: MTF to współczynnik przenoszenia modulacji obiektywu,

Kp – kontrast obrazu po przejściu przez obiektyw,

Ko – kontrast obrazu oryginalnego przed obiektywem.

Czym jest kontrast? Najkrócej rzecz ujmując, to stosunek jasności najjaśniejszego do najciemniejszego punktu obrazu. Aby lepiej to wyjaśnić, wróćmy do rozdzielczości optycznej i testowej tablicy rozdzielczości z pionowymi liniami [2]. Można łatwo zdefiniować kontrast dla pary linii czarna + biała. Opisuje to wzór:

![]() gdzie: Ko – kontrast dla pary linii czarna + biała,

gdzie: Ko – kontrast dla pary linii czarna + biała,

Kp – kontrast po przejściu obrazu przez obiektyw,

Lmax – maksymalna jasność linii białej,

Lmin – minimalna jasność linii czarnej.

Jeśli jako jasność minimalną przyjmiemy wartość 0, a maksymalną wartość 100, otrzymamy Ko równe 1. Załóżmy, że po przejściu przez obiektyw maksymalna jasność linii białej jest równa 70, a minimalna jasność linii czarnej wynosi 10. Po podstawieniu do wzoru (2) otrzymamy Kp równe 0,75. Po podstawieniu wartości Kp i Ko do wzoru (1) otrzymamy współczynnik MTF równy 75%. Oznacza to, że kontrast obrazu odwzorowanego przez obiektyw stanowi 75% kontrastu obrazu oryginalnego (lub inaczej: kontrast obrazu oryginalnego zmalał o 25% po przejściu przez obiektyw).

Dlaczego współczynnik MTF jest tak ważny? Po pierwsze dlatego, że uwzględnia wpływ na kontrast całej konstrukcji obiektywu – wszystkich soczewek, przysłony, powłoki antyrefleksyjnej itd. Po drugie dlatego, że rozdzielczość optyczna obiektywu, określana jako para linii na milimetr (lpmm lub lp/mm) [2], jest często podawana „w komplecie” z MTF, dzięki czemu możemy określić, przy jakiej procentowej utracie kontrastu można mówić o danej rozdzielczości. Jeśli wartość MTF nie została podana, przyjmuje się, że rozdzielczość optyczna lp/mm jest określona dla współczynnika MTF równego 50. Po trzecie – producenci obiektywów często w materiałach katalogowych prezentują wykres MTF w funkcji liczby przysłony, co od razu pozwala ocenić, jak obiektyw radzi sobie z przenoszeniem obrazu w różnych warunkach oświetleniowych i przy różnej głębi ostrości.

Obiektyw

Obiektyw to przyrząd optyczny przenoszący obraz obserwowanego obiektu na matrycę światłoczułą przetwornika obrazowego kamery. Jest okiem kamery, a jego jakość i charakterystyka mają pierwszorzędne znaczenie dla wszystkich procesów obróbki obrazu. Inwestycję w najdoskonalszą kamerę bardzo wysokiej rozdzielczości, wyposażoną w wysokiej jakości procesor DSP może zniweczyć obiektyw słabej jakości.

Dla obiektywu nie ma uniwersalnego wzoru matematycznego opisującego jego działanie, gdyż poszczególne modele mogą się od siebie znacznie różnić liczbą soczewek, ich rodzajem, materiałem, z którego są wykonane, odległościami pomiędzy soczewkami itd. Wzorem przybliżonym, który można zastosować, jest równanie soczewki opisane w 2. części cyklu „Optyka dla każdego”. Na szczęście podstawowego parametru obiektywu, jakim jest ogniskowa, nie musimy wyliczać samodzielnie, producent zawsze go podaje.

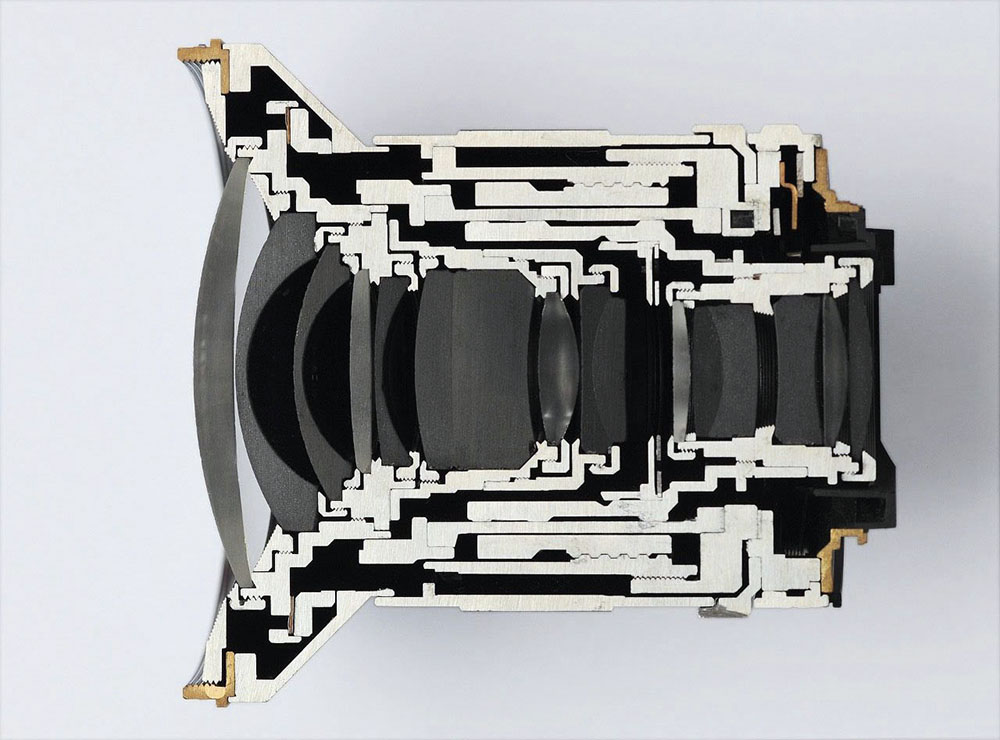

Przykładowy obiektyw w przekroju przedstawiono poniżej na fot.

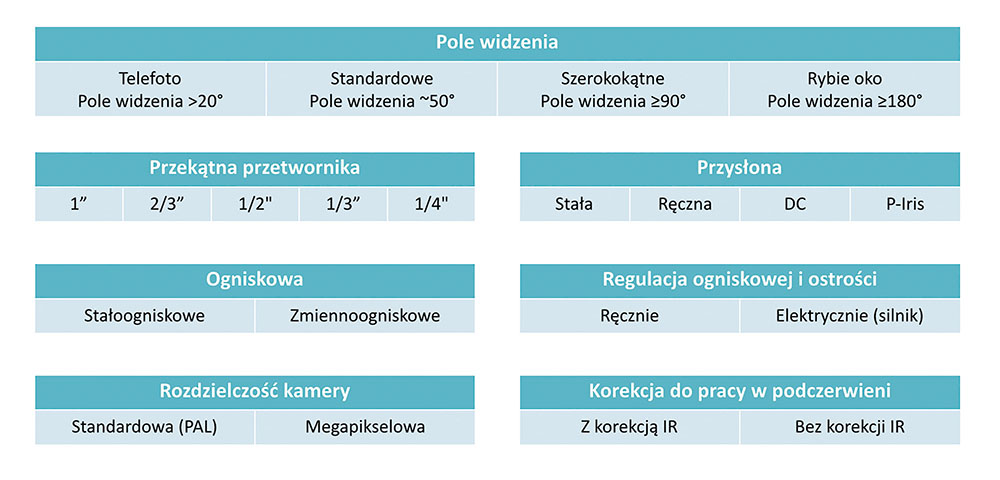

Jego budowa może być złożona – automatyka przysłony, sterowanie ostrością, wiele różnych soczewek, pierścieni itd. Jeszcze bardziej skomplikowany jest obiektyw z elektryczną regulacją ogniskowej i ostrości. Wszystko zależy od konkretnego rodzaju obiektywu i wymaganego zestawu funkcji i parametrów. Ogólne podsumowanie klasyfikacji obiektywów podano w tabeli.

Kryteriów klasyfikacji jest kilka. Pierwszym i chyba najbardziej oczywistym jest pole widzenia. Kolejnym jest wielkość przetwornika obrazu, do którego dobierany jest obiektyw. I tu na chwilę warto się zatrzymać i zastanowić: co się stanie, gdy do kamery z przetwornikiem 1/2” zamontujemy obiektyw 1/3”? Powierzchnia obrazowania obiektywu jest mniejsza od powierzchni przetwornika, więc w efekcie na obrazie z kamery otrzymamy obraz nie tylko „za obiektywem”, ale także krawędzi obudowy samego obiektywu, co nie jest zjawiskiem pożądanym. W sytuacji odwrotnej, czyli w przypadku zamontowania obiektywu 1/2” do kamery z przetwornikiem 1/3”, otrzymamy wprawdzie obraz normalny, ale o mniejszym polu widzenia niż wynikałoby to z ogniskowej obiektywu (część pola widzenia obiektywu jest w takim przypadku niewykorzystana). Najlepszym pomysłem jest zatem dobór wielkości powierzchni obrazowania obiektywu równej wielkości przetwornika.

Kryteriów klasyfikacji jest kilka. Pierwszym i chyba najbardziej oczywistym jest pole widzenia. Kolejnym jest wielkość przetwornika obrazu, do którego dobierany jest obiektyw. I tu na chwilę warto się zatrzymać i zastanowić: co się stanie, gdy do kamery z przetwornikiem 1/2” zamontujemy obiektyw 1/3”? Powierzchnia obrazowania obiektywu jest mniejsza od powierzchni przetwornika, więc w efekcie na obrazie z kamery otrzymamy obraz nie tylko „za obiektywem”, ale także krawędzi obudowy samego obiektywu, co nie jest zjawiskiem pożądanym. W sytuacji odwrotnej, czyli w przypadku zamontowania obiektywu 1/2” do kamery z przetwornikiem 1/3”, otrzymamy wprawdzie obraz normalny, ale o mniejszym polu widzenia niż wynikałoby to z ogniskowej obiektywu (część pola widzenia obiektywu jest w takim przypadku niewykorzystana). Najlepszym pomysłem jest zatem dobór wielkości powierzchni obrazowania obiektywu równej wielkości przetwornika.

Następnym kryterium klasyfikacji obiektywów jest rodzaj przysłony. Jest tu spory wybór, począwszy od najprostszej przysłony stałej, przez regulowaną ręcznie, na automatyce typu DC i P-Iris skończywszy. W przypadku przysłony automatycznej typu DC mechanizmem przysłony steruje kamera. Podobnie jest w przypadku przysłony typu P-Iris, ale mamy tu dużo większą precyzję kontroli głębi ostrości [2].

Innym kryterium jest ogniskowa. Obiektywy stałoogniskowe narzucają stałe pole widzenia, ale są tańsze od zmiennoogniskowych, gdyż nie mają mechanizmu zmiany ogniskowej (zoom), dodatkowych soczewek, mechanizmu przesuwania ich względem siebie itd. W wielu przypadkach wybór kamery z wbudowanym obiektywem stałoogniskowym (np. kopułkowe) pozwala na spore oszczędności, szczególnie przy większej liczbie kamer. Ogniskowa w obiektywach zmiennoogniskowych może być regulowana ręcznie lub za pomocą miniaturowego silnika, podobnie jak ostrość.

Kolejne kryterium to rozdzielczość kamery, dla której dany obiektyw jest właściwy. Rozdzielczość można umownie podzielić na standardową (właściwą np. dla starych kamer analogowych o rozdzielczości 720 x 576 pikseli) i megapikselową. Podkreślam, że jest to podział bardzo umowny, a temat rozdzielczości optycznej poruszałem szczegółowo w poprzedniej części cyklu.

Pole widzenia

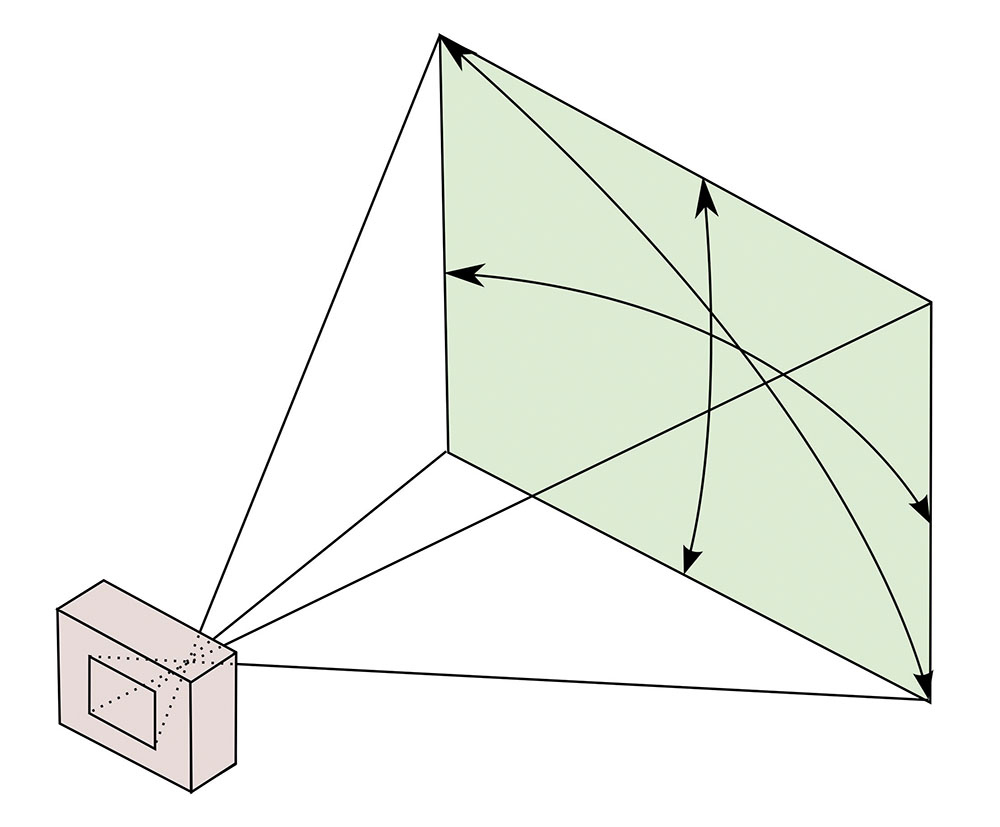

Po ogniskowej drugim niezwykle ważnym parametrem obiektywu jest jego pole widzenia. Typowy przetwornik obrazu w kamerze telewizji dozorowej ma kształt prostokąta, można zatem określić dla niego trzy obszary pola widzenia: poziome, pionowe lub po przekątnej (rys. 1).

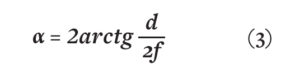

Jak pokazano na rys. 1, pole widzenia zależy nie tylko od ogniskowej obiektywu, ale także od wielkości matrycy przetwornika obrazowego. Kąt widzenia dla każdego boku pola widzenia można obliczyć z prostego wzoru, korzystając z funkcji arcus tangens [3]:

gdzie: alfa – szukany kąt widzenia,

gdzie: alfa – szukany kąt widzenia,

d – rozmiar przetwornika obrazowego dla boku odpowiadającego szukanemu kątowi

(poziomy, pionowy lub przekątna),

f – ogniskowa obiektywu.

W praktyce nie musimy robić obliczeń „na piechotę”, ponieważ chyba każdy producent kamer dozorowych ma obecnie w swoich zasobach różnego rodzaju kalkulatory pola widzenia. Dostępne są też programy wspomagające projektowanie, które potrafią automatycznie wyrysować pole widzenia na podkładzie graficznym (np. mapa terenu) na podstawie wprowadzonych danych o ogniskowej, przetworniku i odległości.

Dobór obiektywu do uzyskania pożądanego pola widzenia jest jednym z kluczowych elementów procesu projektowania systemu telewizji dozorowej, szczególnie w kontekście norm i rozporządzeń precyzujących wymogi na takie systemy w zakresie detekcji, identyfikacji, obserwacji ogólnej itd.

Przejdę teraz do zagadnień związanych stricte nie tyle z optyką, ile z elektronicznym przetwarzaniem obrazu. Są jednak tak bardzo istotne, że w ujęciu dotyczącym kamer telewizji dozorowej nie sposób ich pominąć.

Migawka

W profesjonalnych aparatach fotograficznych migawka jest urządzeniem fizycznie otwierającym dopływ światła do przetwornika (lub kliszy fotograficznej) na ściśle określony czas. W zależności od typu może to być np. zestaw prostokątnych płytek (migawka szczelinowa), listków w kształcie sierpa (migawka centralna) lub inna konstrukcja. W niektórych rozwiązaniach migawka centralna może być jednocześnie przysłoną (np. w cyfrowych aparatach kompaktowych starszej generacji). Zrobieniu zdjęcia profesjonalnym aparatem towarzyszy najczęściej wyraźnie słyszalny trzask lub pstryknięcie (w tanich aparatach kompaktowych jest on emulowany odtworzeniem dźwięku przypominającego takie pstryknięcie). Jest to właśnie moment zadziałania mechanizmu migawki (a przycisk, którym robimy zdjęcie, nosi nazwę spustu migawki).

Nas jednak interesuje migawka w kamerze telewizji dozorowej, gdzie można ją w zasadzie zaliczyć do cyfrowej, elektronicznej obróbki obrazu. Stąd też pochodzi jej nazwa – migawka elektroniczna, często oznaczana skrótowcem AES (Automatic Electronic Shutter). Rola migawki ma na tyle duży wpływ na finalny obraz generowany przez kamerę, że należy jej poświęcić uwagę, szczególnie że migawki typu AES są obecnie powszechnie stosowane w aparatach fotograficznych smartfonów, a nawet modelach profesjonalnych jako uzupełnienie migawki mechanicznej (migawka hybrydowa). Rozwiązanie to zapewnia wiele korzyści w porównaniu z migawką mechaniczną – bardzo duże prędkości działania, bezgłośna praca (ważne np. przy fotografowaniu dzikich zwierząt), brak elementów mechanicznych (skracających trwałość układu), duży zakres regulacji czasu ekspozycji.

Jak zatem jest realizowana funkcja migawki elektronicznej? Otóż przetwornik obrazu „zbiera” dane o obrazie tylko w momencie podania odpowiednich sygnałów elektrycznych na jego wejścia sterujące. Ich częstotliwość określa czas, w jakim przetwornik odczytuje dane o oświetleniu swojej powierzchni. Regulacja tego czasu odpowiada regulacji czasu migawki mechanicznej. W praktyce proces sterowania migawką przetwornika jest dość złożony w zależności od układu może to być „przemiatanie” kolejnych wierszy matrycy (migawka postępowa) lub całościowa obsługa wszystkich pikseli (migawka globalna).

Migawka elektroniczna ma jeszcze jedną zaletą wynikającą z prędkości jej działania: szybka migawka przy dobrym oświetleniu pozwala na zmniejszenie otworu przysłony, co daje dużą głębię ostrości obrazu.

Migawka, liczba klatek i WDR – jak to pogodzić?

Omawiając migawkę, nie sposób pominąć dwóch bardzo istotnych zagadnień ściśle z nią związanych – liczby klatek obrazu generowanych przez kamerę oraz funkcji WDR (Wide Dynamic Range), czyli szerokiego zakresu dynamiki obrazu. Do napisania tego podrozdziału zainspirowało mnie dość powszechne wśród instalatorów przekonanie, że duża liczb klatek na sekundę przekłada się na lepiej uchwycone, ostre i wyraźne szybko poruszające się obiekty. Rzeczywiście, duża liczba klatek czasem się przydaje, np. gdy trzeba szczegółowo zobrazować poszczególne fazy ruchu dynamicznie poruszającego się obiektu. Jednak dla uzyskania właściwej ostrości i wyrazistości obiektu w tych fazach ruchu o wiele większe znaczenie ma prędkość migawki.

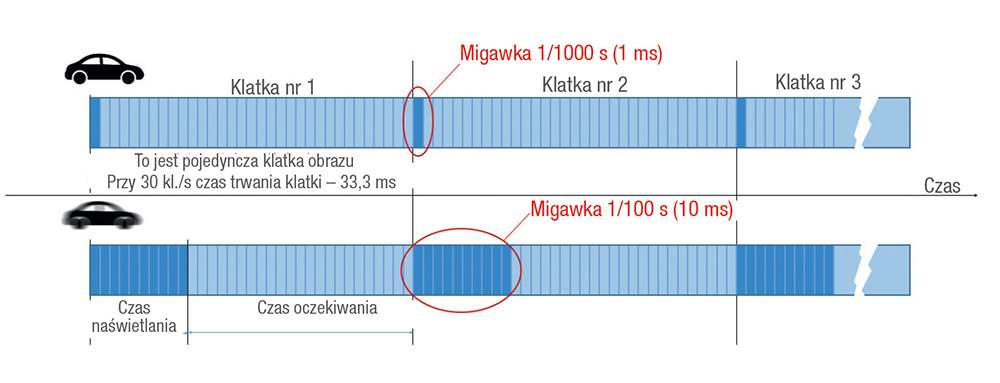

Posłużę się tu przykładem kamer do rozpoznawania tablic rejestracyjnych (LPR – License Plate Recognition lub ANPR – Automatic Number Plate Recognition). Aby uzyskać wyraźny, a przede wszystkim ostry obraz tablicy rejestracyjnej, lepszą konfiguracją będzie prędkość 10 kl./s + migawka 1/1000 sekundy niż prędkość 60 kl./s + migawka 1/250 sekundy. I to nie tylko ze względu na przetwarzanie danych w algorytmie rozpoznawania tablic. W wyjaśnieniu pomoże rys. 2.

Przy prędkości 30 kl./s czas trwania pojedynczej klatki obrazu wynosi 33,3 ms (30 · 33,3 ms ? 1000 ms). Czy to oznacza, że przez całe 33,3 ms przetwornik „czyta” obraz? Nie. To oczywiście zależy od aktualnej prędkości migawki. Jeśli kamera obserwuje szybko poruszający się obiekt, np. samochód na drodze, a migawka jest ustawiona na 1/1000 s, to przetwornik będzie „łapał” obraz właśnie przez ten czas i już po upływie 1 ms zamknie okno naświetlania, czekając kolejne 23,3 ms na następną klatkę obrazu.

Konsekwencje tego są dwie. Po pierwsze, szybko poruszający się obiekt będzie eksponowany na przetworniku przez krótką chwilę, więc jego obraz w ruchu będzie ostry i wyraźny. Po drugie, czas „zbierania” światła z przetwornika jest bardzo krótki, a więc obraz będzie miał słabą jasność. Scena musi być zatem bardzo dobrze oświetlona światłem widzialnym (np. słoneczny dzień) lub promieniowaniem podczerwonym, gdy pracuje w trybie czarno-białym (tak się właśnie dzieje w kamerach ANPR). Jeśli prędkość migawki zmniejszymy dziesięciokrotnie, do 1/100 s, to przetwornik będzie „czytał” obraz przez 10 ms i czekał 13,3 ms na kolejną klatkę. Obraz uzyska lepszą jasność, gdyż czas ekspozycji przetwornika będzie 10x dłuższy, ale szybko poruszający się pojazd stanie się w kadrze rozmazany, bo jego faza ruchu będzie się eksponować 10x dłużej niż w poprzednim przypadku.

Sytuacja ta wyjaśnia także efekt „smużenia” (w żargonie często nazywanego „duchem”) występującego np. w nocy, gdy automatyka ekspozycji kamery stara się maksymalnie naświetlić matrycę przetwornika, korzystając z dłuższych czasów migawki. W fotografii długie czasy migawki dla ekspozycji szybko poruszających się obiektów wykorzystuje się nieraz celowo, np. by uzyskać efektowne zdjęcia „rozciągniętych” świateł samochodowych w nocnym ruchu ulicznym.

Drugie zagadnienie dotyczy relacji prędkości migawki i działania funkcji WDR, która tak balansuje kontrast, aby na obrazie nie występowały miejsca prześwietlone ani ukryte w cieniu. Przykładowo, sylwetka człowieka stojącego w ciemnym pomieszczeniu na tle szklanych drzwi, przez które wpada ostre światło słoneczne, „zginie” na obrazie i nie będzie można rozpoznać takiej osoby – światło z zewnątrz oślepi kamerę, nie pozwalając także dostrzec szczegółów za drzwiami.

Rozwiązaniem jest właśnie funkcja WDR, która radzi sobie z taką sytuacją. Kluczem jest tu migawka. Spójrzmy ponownie na rys. 2. Jak widać 33,3 ms to całkiem sporo, bo można w czasie trwania jednej klatki wykonać (jedno po drugim) dwa, a nawet trzy lub cztery ujęcia z różnymi czasami migawki. Wracając do przykładu ze szklanymi drzwiami, wykonanie ujęcia z prędkością np. 1/1000 s pozwoli uchwycić elementy skąpane w świetle, za drzwiami, ponieważ krótki czas migawki to ciemniejszy obraz. Z kolei drugie ujęcie z prędkością np. 1/50 s pozwala na dobre naświetlenie sylwetki osoby stojącej w ciemnym pomieszczeniu. Złożenie tych dwóch ujęć i uśrednienie kontrastu z obu z nich da w efekcie wyraźny obraz zarówno osoby, jak i tła za drzwiami. Tak właśnie w wielkim skrócie działa funkcja WDR (w rzeczywistości proces składania ujęć jest bardziej złożony niż proste uśrednianie).

Mamy przy okazji wyjaśnienie, dlaczego często po włączeniu funkcji WDR maksymalna liczba generowanych przez kamerę klatek na sekundę spada o połowę (o czym producenci kamer najczęściej nie wspominają w karcie katalogowej). Otóż aby przetwornik „zdążył” wygenerować klatkę obrazu, w trakcie której wykonuje dwa ujęcia z dwiema (lub więcej) prędkościami migawki, potrzebuje na to więcej czasu. Czasu, który można uzyskać, zwiększając długość trwania klatki, co oczywiście automatycznie skutkuje spadkiem liczby generowanych klatek. Nie zawsze musi tak być, wszystko zależy od rodzaju zastosowanego w kamerze przetwornika obrazu i pożądanej prędkości odświeżania (są kamery, które potrafią generować 30 czy nawet 60 kl./s przy włączonej funkcji WDR). Ta sama kwestia wyjaśnia również, dlaczego bardzo często po włączeniu funkcji WDR zakres ręcznej regulacji prędkości migawki elektronicznej kamery zostaje zawężony lub w ogóle możliwość regulacji migawki zostaje zablokowana (zależy to od konkretnego modelu kamer i producenta).

Trójkąt ekspozycji

Wiadomo już, co to są przysłona, migawka, czułość i głębia ostrości. Jedną z najistotniejszych kwestii związanych z optyką – zarówno w fotografii, jak i telewizji dozorowej – jest zrozumienie wzajemnych zależności między tymi parametrami ekspozycji. Ekspozycja to ilość światła padającego na powierzchnię światłoczułą przetwornika obrazu (w fotografii analogowej na powierzchnię kliszy fotograficznej), przy czym ta ilość jest zdeterminowana przez trzy czynniki: wielkość przysłony, migawkę i czułość [4]. W zrozumieniu zależności między tymi parametrami pomoże trójkąt ekspozycji przedstawiony na rys. 3.

W sytuacji, gdy skuteczność działania systemu zależy od wielu powiązanych ze sobą parametrów, najczęściej pojawia się kwestia kompromisu pomiędzy wartościami tych parametrów. Tak też jest w przypadku trójkąta ekspozycji. Każdy bok trójkąta oznacza parametr ekspozycji mający bezpośredni związek z określoną wielkością fizyczną. Zaczynając od lewego boku – prędkość migawki ma wpływ na odwzorowanie ruchu, co wyjaśniłem, opisując działanie migawki. Prawy bok trójkąta to czułość ściśle związana z poziomem szumów przetwornika obrazu. Dolny bok natomiast to przysłona, od której zależy ilość światła padającego na przetwornik, a także głębia ostrości. Najważniejsza jest jednak wzajemna zależność wszystkich tych parametrów.

Przykładowo, aby uzyskać dobrej jakości obraz szybko poruszającego się obiektu, potrzebujemy szybkiej migawki. To jednak spowoduje spadek jasności obrazu, bo czas ekspozycji będzie krótki. Powstaje zatem problem właściwego obrazowania ruchu w słabych warunkach oświetleniowych. Można to skompensować większym otwarciem przysłony, ale im bardziej ją otworzymy, tym krótsza będzie głębia ostrości obrazu i mniejszy zasięg skutecznej obserwacji. Trzeba więc wykorzystać trzeci bok trójkąta i przy optymalnej wartości przysłony zwiększyć czułość, ale też w granicach rozsądku, bo w przeciwnym razie popsujemy obraz dużą zawartością szumów. Z powyższego przykładu wynika, że zawsze trzeba znaleźć równowagę między czasem migawki, czułością i wartością przysłony, a zmianę jednego z tych parametrów powinniśmy niejako skompensować dostosowaniem dwóch pozostałych.

W praktyce telewizji dozorowej sprawa się nieco komplikuje. O ile czułość można regulować w szerokim zakresie w aparatach fotograficznych (tzw. wartość ISO), o tyle w kamerach CCTV/VSS takiej możliwości nie ma. Czułość jako wartość katalogowa wyrażona jednostką lux jest podawana w parze z liczbą przysłony (i czasami także wartością IRE)1). W kamerach z mechanicznie odsuwanym filtrem podczerwieni jest podawana odrębnie dla trybu kolorowego i czarno-białego. To wartość stała, a mechanizm „podciągania” jasności bazuje na automatycznej regulacji wzmocnienia sygnału wizyjnego ARW (AGC – Automatic Gain Control). Poziom wzmocnienia można najczęściej regulować skokowo, jednak zbyt duże wzmocnienie AGC (analogicznie jak zbyt duża wartość ISO w aparacie fotograficznym) może spowodować wzrost „śnieżenia” na obrazie, bo oprócz wzmocnienia użytecznego sygnału wzmocnieniu ulegną także szumy przetwornika i elektroniki obróbki obrazu. Ponadto w obiektywach z przysłoną automatyczną (DC lub P-Iris) automatyka kamery musi znaleźć „złoty środek” między czasem elektronicznej migawki a wartością przysłony. Zdarza się, że niedbale napisane oprogramowanie układowe (firmware) kamery rujnuje bardzo dobre parametry jej przetwornika i drogiego obiektywu.

Na zakończenie

Kończąc cykl „Optyka dla każdego”, warto poświęcić chwilę na podsumowanie. Wiemy, czym jest światło, jakie zjawiska mogą zachodzić z jego udziałem, co to jest widmo i fala elektromagnetyczna, jak ogólnie działa ludzkie oko i czemu zawdzięczamy widzenie barwne. Wiemy, co to jest optyka geometryczna, promień, soczewka, refrakcja, dyfrakcja oraz dlaczego dzięki dyspersji możemy zobaczyć tęczę. Poznaliśmy także pojęcia rozdzielczości optycznej, przysłony, głębi ostrości, aberracji sferycznej i chromatycznej oraz wiemy, jak te aberracje kompensować. Wiemy, co to jest plamka Airy’ego i czym się różni od dysku Airy’ego, jak działa i do czego służy mechanicznie odsuwany filtr podczerwieni w obiektywie, co to jest migawka, kontrast, MTF, ekspozycja i trójkąt ekspozycji. To sporo informacji i solidne podstawy do dalszego zgłębiania wiedzy w różnych fachowych źródłach.

Czego nie wiemy? Optyka to tak obszerny dział fizyki, że nie sposób poruszyć wszystkich zagadnień, nawet ograniczając się do zakresu telewizji dozorowej. Czułość i IRE, Bokeh, koma, astygmatyzm, temperatura barwowa, soczewka Fresnela to przykładowe pojęcia, których znaczenia warto poszukać choćby w Wikipedii. Budowa i działanie przetworników obrazowych, transmisja obrazu, strumienie i kompresja danych – te aspekty, choć niewątpliwie ściśle związane z telewizją dozorową, należy jednak przypisać do kategorii przetwarzania obrazu i teorii sygnałów, a nie optyki sensu stricto (a zagadnienia te są na tyle obszerne, że każde zasługuje na osobny cykl artykułów).

1) Kwestie dotyczące sposobów pomiaru i podawania parametrów czułości w kamerach CCTV są na tyle obszerne, że wymagają szczegółowego opisu, wykraczającego poza ramy tego artykułu.

Literatura: [1] C.S. Williams, Introduction to the Optical Transfer Function, SPIE – The International Society for Optical Engineering, Bellingham, Washington 2002. [2] Zob. Optyka dla każdego. Część 3. „A&S Polska” nr 3/2019. [3] D.G. Hunder, C.E. West, Last-Minute Optics. A Concise Review of Optics, Refraction, and Contact Lenses, Slack Incorporated, wydanie 2, Thorofare 2010. [4] Hsien-Che Lee, Introduction to Color Imaging Science, Cambridge University Press, Cambridge 2005.

|

|