Rybim okiem

Jan T. Grusznic

Kamery panoramiczne coraz częściej stanowią podstawę rozwiązań wizyjnych, zwłaszcza w segmencie retail. Pozwalają na szybkie wychwycenie ruchu w przestrzeniach dozorowanych, zapewniając jednocześnie obserwację jego ciągłości. Są nieocenione jako poglądowa mapa zdarzeń. Zastosowane w sklepach czy salonach prasowych mierzą długość kolejek, czas przebywania w strefach promocyjnych, śledzą podatność ludzi na kampanie marketingowe. Wersje zewnętrzne kamer panoramicznych zastąpiły lustra do przeglądu podwozia pojazdów. Potencjalnych rozwiązań, w których można wykorzystać kamery panoramiczne, jest znacznie więcej.

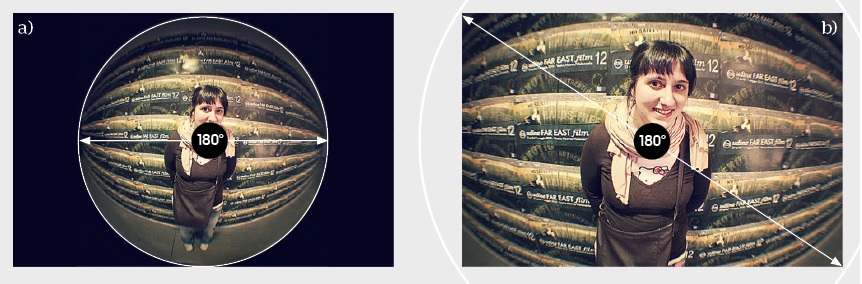

Sercem kamer panoramicznych jest zespół soczewek, który umożliwia utworzenie obrazu –popularnie zwanego w fotografii rybim okiem (fisheye) – o bardzo szerokim kącie widzenia, w zakresie 180–220°. Obiektyw ten charakteryzuje się silną, nieskorygowaną dystorsją beczkowatą, zapewniającą projekcję obrazu panoramicznego. W zależności od sposobu, w jaki został skonstruowany i jak światło rzutuje na element światłoczuły, obiektywy typu „rybie oko” dostarczają różne obrazy. Te „zamknięte w kole”, spotykane najczęściej, są wynikiem „wpisania” obrazu w przetwornik, stąd charakterystyczne ciemne obszary po prawej i lewej stronie kadru (rys. 1a).

Wykazujący silną dystorsję obraz, ale wypełniający cały kadr bez widocznych czarnych stref też należy do rozwiązań z rodziny kamer hemisferycznych. Powstaje w wyniku opisania obrazu z obiektywu panomorficznego na przetworniku (rys. 1b) i odpowiada kątowi widzenia 180°, ale po przekątnej kadru.

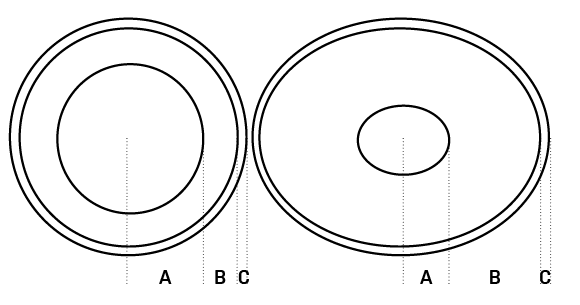

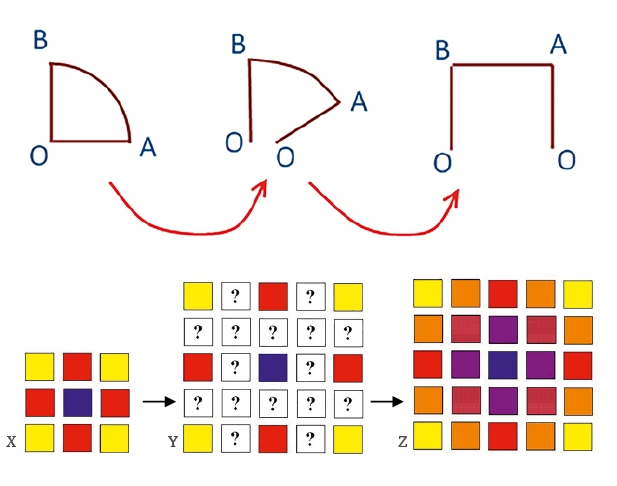

Sama konstrukcja obiektywu jest oparta na specjalnie modelowanych soczewkach, które dzięki odpowiednim „zakrzywieniom” dostarczają obraz o wyższej szczegółowości (ponieważ wykorzystują większą liczbę pikseli w danej strefie) w obszarze oddalonym od środka optycznego obiektywu. Od strony użytkowej podstawową różnicą pomiędzy obiektywami typu „rybie oko” a panomorficznymi jest strefa, w której uzyskuje się obraz najwyższej jakości. Na rys. 2 przedstawiono schematy rzutów obrazu na przetwornik przez omawiane zespoły soczewek. Dla obiektywów panomorficznych część obrazu o najwyższej szczegółowości przypada na strefę B, a dla obiektywów typu „rybie oko” dla strefy A.

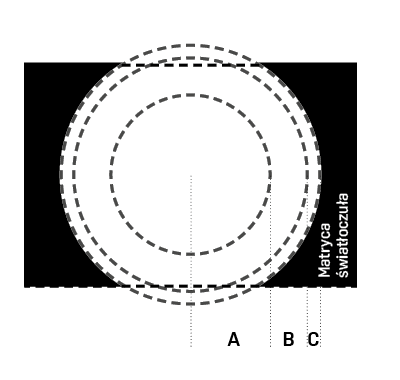

Strefa C w obu przypadkach dostarcza obrazy gorszej jakości ze względu na silną dystorsję i aberrację sferyczną. Producenci jednoprzetwornikowych kamer panoramicznych, chcąc wyeliminować powyższe ograniczenia, stosują prosty zabieg: rzutują obraz z soczewek fisheye nieco poza przetwornik, zwiększając tym samym użyteczną strefę obserwacji – strefę A (rys. 3). Dzięki temu kamery z tradycyjnymi obiektywami fisheye traktuje się jako rozwiązania bardziej uniwersalne ze względu na możliwość instalacji na powierzchniach równoległych do podłoża i na ścianach. Być może konstrukcja obiektywu panomorficznego w pewnym stopniu ogranicza zastosowanie kamery tylko do sufitów i biurek, za to świetnie sobie radzi z wizualizacją osób uczestniczących np. w telekonferencji.

Podana przykładowa rozdzielczość 2 Mpix nie jest ograniczeniem. Obecnie takie rozwiązania stanowią alternatywę dla kamer panoramicznych – droższą, ale dostarczającą obraz o wyższej jakości na obrzeżach kadru, w porównaniu z uzyskanymi przez panoramiczne kamery jednoprzetwornikowe.

| Warto zapamiętać: Im więcej wykorzystamy przestrzeni ze strefy, która nie jest optymalna dla tego rodzaju soczewki, tym gorszej jakości obraz uzyskamy. Dlatego też należy unikać przekształcania części obrazu znajdujących się w strefie C, a podwójną panoramę wykorzystywać z soczewkami panomorficznymi. Jeśli nie jest to możliwe, warto rozważyć zainstalowanie kamery na ścianie i wykorzystanie przekształcenia panoramicznego (rys. 4b). |

Przekształcenia, mapowanie i inne magiczne sztuczki

Obiektywy stosowane w rozwiązaniach obserwacji dookólnej mogą mieć różną budowę, zatem obrazy przez nie tworzone będą się od siebie różnić. Informacja o konstrukcji obiektywu jest kluczowa dla oprogramowania, którego zadaniem jest przekształcenie zdeformowanego obrazu do obrazu bliskiego rzeczywistemu (dewarping). Właściwe przekształcenie widoku hemisferycznego wymagana specjalistycznej wiedzy dotyczącej mapowania obrazów, czyli sposobu, w jaki jest on rzutowany na płaszczyznę przetwornika.

Późniejsza wymiana obiektywu na dowolny będzie skutkowała pogorszeniem jakości przetworzonego obrazu hemisferycznego.

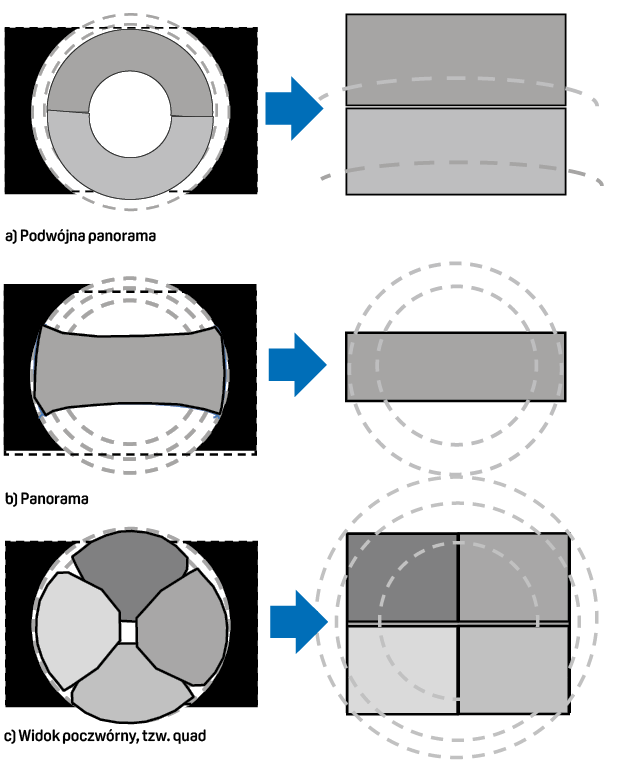

Najbardziej popularnymi przekształceniami w kamerach 360° są:

– podwójna panorama, dająca bardzo dobre rezultaty przy wykorzystaniu soczewek anamorficznych (rys. 4a),

– panorama dająca bardzo dobrą jakość widzenia dla kamer instalowanych np. na ścianie, z tradycyjnymi soczewkami typu „rybie oko” (rys. 4b),

– quad, czyli układ 2 x 2 zapewniający obserwację planu z przekształceniem do 4 obrazów sąsiadujących ze sobą. Dobra jakość dla soczewek tradycyjnych typu fisheye oraz panomorficznych,

– wirtualny PTZ, który wynika bezpośrednio z możliwości przekształcania obrazu hemisferycznego do formatu quad. Przetwornik o odpowiednio wysokiej rozdzielczości umożliwia kilkukrotne powiększenie cyfrowe poszczególnych fragmentów obrazu.

Schematy widoczne na rys. 4a, 4b i 4c należy traktować jako poglądowe, ponieważ w trakcie wykonywania przeliczeń część informacji zostaje utracona.

Przeznaczenie: ogólny dozór wizyjny

Kamery hemisferyczne służą do ogólnego podglądu zdarzeń w nadzorowanej strefie. Takie funkcje, jak rejestracja znaków szczególnych, identyfikacja, rozpoznanie czy obserwacja daleko wychodzą poza zakres możliwości tych rozwiązań. Kamery panoramiczne sprawdzają się w aplikacjach nadzoru tłumu. Według wskazań polskiej normy PN-EN 62676-4:2015-06 [4] osoba ma być ujęta w kadrze w proporcji 80 mm wysokości przypadających na 1 piksel przetwornika obrazu lub w wizyjnej detekcji ruchu (40 mm/piksel).

Niestety wyznaczenie zakresu obserwowanej przestrzeni z uwzględnieniem wytycznych normy to nie lada wyzwanie. Obiekt znajdujący się w tej samej odległości w osi optycznej obiektywu jest reprezentowany przez większą liczbę pikseli niż ten sam obiekt w tej samej odległości, ale z dala od osi optycznej. Również odległość obiektu od punktu instalacji kamery ma wpływ na zmianę stosunku milimetry/piksele. Dostępne na rynku kalkulatory do określenia rozdzielczości obiektu na obrazie, przy znanych wartościach rozdzielczości przetwornika, ogniskowej i kąta obserwacji opierają się na modelu prostoliniowym, znajdują więc zastosowanie do obliczeń dla podstawowych soczewek o niedużej dystorsji. Nie są jednak przydatne w przypadku obiektywów typu „rybie oko” ze względu na zbyt silne zniekształcenia w całym kadrze. Ponadto uzyskanie poprawnych wyników obliczeń nie jest możliwe bez informacji o faktycznej wielkości naświetlonej części przetwornika. Nie można zakładać, że wykorzystywana jest cała matryca, np. 5 Mpix (1920 x 2560) (czarne obszary w skrajnych częściach obrazu). Jeżeli rzutowany obraz jest w pełni wpisany w przetwornik, do obliczeń można użyć wzoru na pole koła – ?r2. Promień w tym przypadku będzie równy 1 liczby pikseli wysokości przetwornika, czyli 1920/2 = 960. A zatem ? x 9602 = ~2 900 000 pix, czyli niecałe 3 Mpix!

Zaskakujące, zwłaszcza że w kartach katalogowych jest podawana rozdzielczość całego przetwornika, co jest poprawne tylko dla obrazów tzw. full fisheye, gdzie przetwornik jest wpisany w rzutowany obraz, wykorzystując całą matrycę światłoczułą.

W obliczaniu gęstości pikseli (mm/px) pojawia się jeszcze jedna przeszkoda. Wydawać by się mogło, że dodatkowe przekształcenia w obrazie (rys. 4a, 4b, 4c) spowodują dodatkowy spadek liczby pikseli. W zasadzie to jest prawda, ale… W obrazie „przetworzonym” widoczna liczba pikseli może być jednak większa. Wynika to z komputerowej korekcji dystorsji, której zadaniem jest „wyciąganie” krawędzi i prostowanie oryginalnie zakrzywionych przestrzeni w obrazie – brakujące piksele są najczęściej „dorabiane” w podobny sposób, jak w przypadku interpolacji dla kolorowego obrazu o rozdzielczości 3 x 3 piksele do rozdzielczości 5 x 5 (rys. 5).

Artykuł jest skróconą wersją artykułu opublikowanego w wydaniu specjalnym „Systemy Alarmowe” – Kamery panoramiczne 360°, 2014.

Literatura [1] http://www.vision-systems.com//articles/2001/08/philips-csi-selects-iqinvision-iqeye3-camera-for-its-security-products.html [2] Robin Hill i R. & J. Beck, Ltd., Improvements in Photographic Lenses. Patent zarejestrowany w Urzędzie Patentowym Wielkiej Brytanii #GB225,398; nagrodzony grantem 4 grudnia 1924 r. [3] Enhanced Surveillance System Based on Panomorph Panoramic Lenses, Simon Thibault, ImmerVision 2020 University, Montreal, Quebec H3A 2A5 Canada, 2007 [4] Systemy dozoru wizyjnego stosowane w zabezpieczeniach – Część 4: Wytyczne stosowania. [5] http://polymathprogrammer.com/2009/10/29/math-360-fisheye-landscape/ [6] http://www.betterphoto.com/forms/qnaDetail.asp?threadID=28413 [7] http://www.cctv-information.co.uk/i/Light_Transmission_Through_Lenses [8] „Miś”, reż. Stanisław Bareja, 1980 r.

Jan T. Grusznic

z-ca red. naczelnego „a&s Polska”. Z branżą wizyjnych systemów zabezpieczeń związany od 2004 r. Ma bogate doświadczenie w zakresie projektowania i wdrażania rozwiązań dozoru wizyjnego w aplikacjach o rozproszonej strukturze i skomplikowanej dystrybucji sygnałów. Ceniony diagnosta zintegrowanych systemów wspomagających bezpieczeństwo.