Czy inteligentna analiza wizyjna zapobiegnie samobójstwom w celi więziennej Cz. 2.

Technologie informatyczne wspierające operatora systemu monitoringu

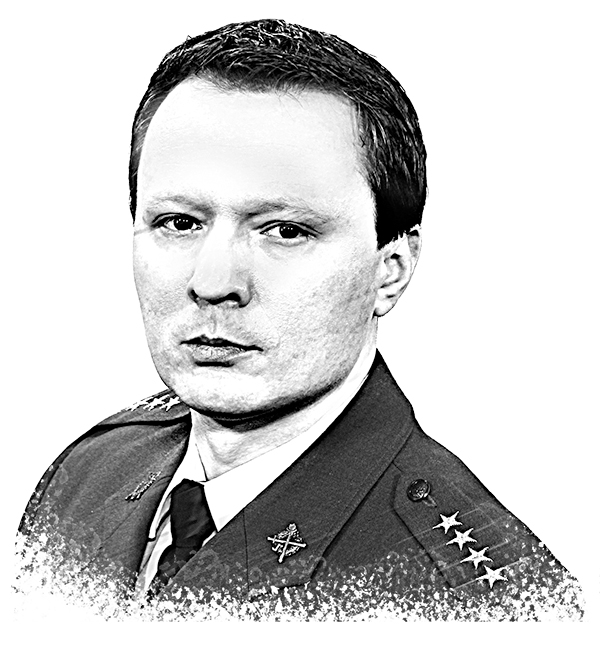

Cezary Mecwaldowski, Robert Poklek

W części pierwszej artykułu (A&S 4/2021) autorzy wskazali na wyniki przeprowadzonych badań operatorów systemu dozoru wizyjnego w polskiej Służbie Więziennej oraz potrzebę ich wsparcia w stałej obserwacji zachowania osadzonych, szczególnie w celu zapobiegania samobójstwom.

Za rozwiązanie najbardziej obiecujące uznano inteligentną analizę treści wizyjnej (intelligent video analytics – IVA, video content analysis – VCA). Nie jest to nowość w więziennictwie. Na świecie prowadzi się wiele badań w tym zakresie – od Korei Płd., Chin, przez Niemcy, Wlk. Brytanię, USA, po badania autorów w Polsce. Odpowiedź na jedno pytanie rodzi dwa kolejne, dlatego badania są kontynuowane i świadomie nie zdecydowano się na wdrożenia. Od dawna trwają próby zaadaptowania tej technologii w zakresie wykrywania zachowań ludzkich – od łatwo dostrzegalnych, np. pozostawienie przedmiotu, przekroczenie linii, kierunek i prędkość poruszania, błądzenie, odległość pomiędzy osobami, postać leżąca, stojąca itp., po te, które trudniej zaobserwować, np. zmiana stanu emocjonalnego, sposobu chodzenia czy zachowania wynikające z długiego czasu obserwacji.

Autorzy przestrzegają przed stosowaniem technologii IVA bez ich wcześniejszych badań i adaptacji przy rozróżnieniu stanowisk i ich celów w więzieniach. Należy rozróżnić stosowanie dozoru wizyjnego (monitoringu) w zakresie zachowania osadzonych i bezpieczeństwa (bójki, ucieczki, niszczenie mienia itp.) od zapobiegania samobójstwom w celi więziennej.

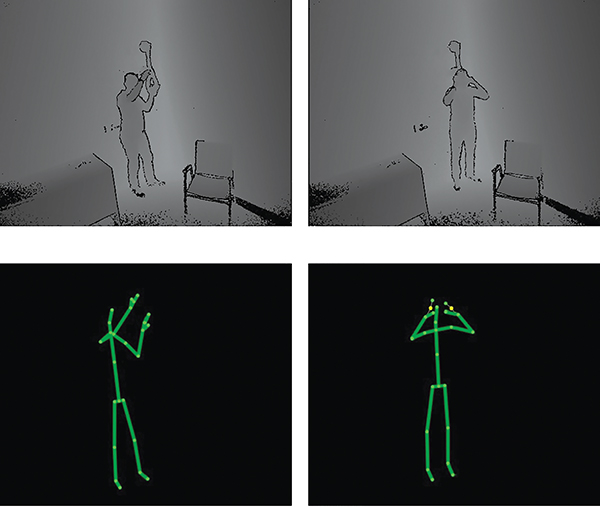

Prowadzone na świecie badania, które mogą znaleźć zastosowanie w zapobieganiu samobójstwom w więzieniach, bazują z reguły na dwóch rozwiązaniach: rozpoznawaniu postawy osoby, dynamiki obrazu (fot. 1) oraz rozpoznawaniu emocji z obrazu twarzy (fot. 2). Zdaniem autorów najsłabszą ich stroną są sytuacje samobójstw w łóżku, gdyż poza osoby nie jest jednoznaczna, a kamera nie może zapewnić odpowiedniego obrazu twarzy. Niestety rozwiązania bazujące wyłącznie na postawie osoby i dynamice obrazu w najlepszym przypadku pozwolą uzyskać alarm z systemu, gdy do próby samobójczej już dojdzie. Nie należy sugerować się przykładami spoza więzień, np. opisywanym w literaturze przypadkiem zapobiegania samobójstwom na mostach w Seulu1. Występują tam zupełnie inne uwarunkowania zachowań samobójczych, przestrzeni i miejsca. Na moście, dzięki możliwości zastosowania detekcji przekroczenia linii lub obszaru, uzyskuje się dodatkowy parametr, który wraz z detekcją „szwendania-błądzenia” pozwala ustalić kryterium i wygenerować alarm z wysokim prawdopodobieństwem zdarzenia suicydalnego. Takich jednoznacznych kryteriów w celi więziennej nie da się ustalić.

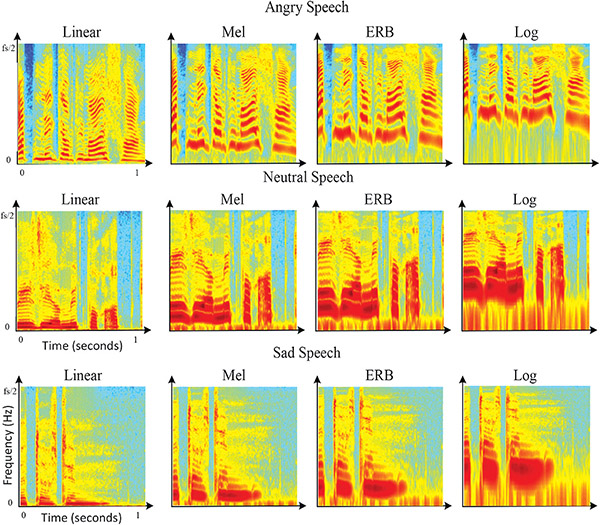

Koncepcja autorów opiera się na rozwiązaniu, którego wynik pozwoli na alarmowanie presuicydalne, suicydalne i postsuicydalne. Jej istotą jest połączenie różnych technologii uczenia maszynowego z rozpoznawaniem postawy, emocji i behawioralnych reakcji osadzonego w celi w długim wymiarze czasowym. Uczenie maszynowe pozwoli na generowanie alarmu nie tylko w sytuacji niedostrzegalnych dla obserwatora zmian obrazu (np. na poziomie pojedynczych pikseli), ale także przy wystąpieniu subtelnych zmian zachowania, poruszania się, gestów, emocji z mimiki lub głosu (fot. 3), ruchów manipulacyjnych dłoni, postawy ciała itp. w długim okresie.

Kolejną niezwykle istotną kwestią jest operator systemu dozoru wizyjnego. Mimo zastosowania algorytmów automatycznej detekcji nadal pełni on nadrzędną decyzyjną funkcję. Analizy przeprowadzone przez autorów doprowadziły do następujących konkluzji: należy jednoznacznie wybrać typ operatora2.

Typ 1 to klasyczny operator monitoringu, który wyłącznie obserwuje obrazy i podejmuje decyzje o wykryciu zdarzenia. Technologia IVA w przypadku implementacji algorytmów do zadań typu 1 będzie takiego operatora rozpraszała, a po czasie stwierdzi, że nie musi obserwować, skoro system za niego weryfikuje zdarzenia (pojawi się naturalny efekt minimalizacji zużycia energii). Jednak niezadziałanie automatycznych algorytmów pozostawia szansę zaobserwowania zdarzenia przez operatora zaangażowanego w obserwację. Typ 2 z kolei to operator, który oczekuje na alarm z innych systemów. Dopiero sygnał uaktywnia operatora, który przyczynę alarmu z systemu IVA weryfikuje z sytuacją na obrazie z kamer. Jego obowiązkiem nie jest ciągła obserwacja i wyszukiwanie zdarzeń w obrazie. Istnieje poważne ryzyko, że gdy algorytm nie zadziała, operator nie zareaguje na zdarzenie. W obszarze przestrzegania prawa do prywatności osadzonego wybór operatora typu 2 jest właściwszy – mimo mniejszej skuteczności (operator nie obserwuje stale osadzonego, robi to wyłącznie w sytuacji detekcji i alarmu zdarzenia wygenerowanego przez IVA).

Źródło: W. Bouachir, R. Noumeir “Automated video surveillance for preventing suicide attempts”

Zastosowanie technologii do rozpoznawania prób samobójczych za pomocą pozycji ciała osadzonego ma słabe strony. Ograniczona przestrzeń celi utrudnia rozpoznanie pozycji ciała, a tym bardziej innych metod samobójstwa. W razie pocięcia, połknięcia leków, trucizny, przedmiotów, podpalenia, porażenia prądem czy uduszenia workiem (w łóżku, i to pod przykryciem) zastosowanie wyłącznie detekcji pozycji ciała jest mało lub w ogóle nieskuteczne w przeciwdziałaniu takim zdarzeniom. Operator otrzyma informację, że do próby samobójczej już doszło.

Analiza zachowań zarejestrowanych bezpośrednio przed dokonaniem czynu samobójczego wykazała, że większość z nich jest typowa i nie odbiega zbytnio od codziennych czynności – osadzony spokojnie realizuje swój plan, jest zdeterminowany, co często nadaje pewność jego ruchom. Jednak cały plan odebrania sobie życia układany jest zdecydowanie wcześniej i wiąże się ze zmianami behawioralnymi (zamyślenie, zmiany stanu emocjonalnego zauważalne na twarzy i w gestach, początkowa nerwowość, próby ukrycia swoich zamiarów, a na końcu pozorna poprawa samopoczucia), które są na tyle subtelne, że obserwator nie jest w stanie ich ze sobą powiązać i skojarzyć jako przygotowanie do samobójstwa. Stąd zaproponowane wprowadzenie przez autorów uczenia maszynowego zachowań osadzonych w celi, poddawane analizie w długich okresach. System uczy się zachowania osadzonych i tworzy wzorzec niezauważalny dla operatora, ale system wykryje nawet subtelne zmiany we wzorcowym zachowaniu. Jak zakładają autorzy, pozwoli to na rzeczywiste alarmowanie presuicydalne i zapobieganie, a nie tylko działanie post factum.

Skuteczność proponowanego połączenia technologii może być mniejsza w sytuacji, kiedy osadzony przebywa krótko w więzieniu, ale rośnie z czasem pobytu i wraz z gromadzonymi danymi w systemie uczącym się zachowań i emocji osadzonego. Mocną stroną koncepcji jest zastosowanie trzech technologii uczenia maszynowego, rozpoznawania pozycji ciała (postawy) osoby i emocji z mimiki twarzy (lub w wariancie głosu, pozwalając także rozpoznawać stan zdrowia, zbliżający się atak serca lub zdrowie psychiczne3). Wykorzystanie mimiki i rozpoznania stanu emocjonalnego osadzonego może być alarmowane bezpośrednio do funkcjonariuszy pracujących z osadzonym w oddziale – ochronie, wychowawcy czy psychologom. Taki funkcjonariusz po otrzymaniu informacji (SMS lub na dedykowany komunikator), że dany osadzony ma obniżony nastrój, depresję lub jest pobudzony, mógłby niemal natychmiast się nim zainteresować.

Rozwiązania rozpoznające stan zdrowia i emocje drastycznie ingerują w sferę prywatności. Istnieje uzasadnione zagrożenie nadużyć w tym zakresie, więc przed wdrożeniem takiej technologii niezbędne są odpowiednie regulacje ustawowe i procedury gwarantujące praworządne stosowanie.

Źródło: Genesis Lab – Emotion Recognition AI

Źródło: M. Lech, M. Stolar, Ch. Best, R. Bolia, Real-Time Speech Emotion Recognition Using a Pre-trained Image Classification Network: Effects of Bandwith Reduction and Companding. Frontiers in Computer Science, 26.05.2020

Natura ludzka ma cechę dążenia do osiągnięcia celu, więc jeżeli celem tym będzie samobójstwo, osadzony z pewnością go dokona mimo trudności. Będzie usiłował „przechytrzyć” system, np. rozbierze się ze specjalnej odzieży, uszkodzi stosowane środki techniczne, przemyci przedmioty itp. Skutek może być dwojaki – dokonanie samobójstwa lub spowodowanie alarmu inteligentnej analizy obrazu, który często generowany, osłabi czujność operatora i wywoła rutynę.

Oprócz opisanego przykładu przeciwdziałania samobójstwom analityka obrazu może wspierać zadania operatora monitoringu oraz pełnić funkcję automatycznego alarmowania w systemach bez operatora. Istotnym argumentem jest kwestia ochrony prywatności, kiedy za bezpieczeństwo odpowiada automatyczny system i nie ma stałej obserwacji przez operatora.

Autorzy już w 2015 r. w Centralnym Ośrodku Szkolenia Służby Więziennej w Kaliszu, w ramach zadań Zespołu Rozwojowo-Badawczego, rozpoczęli projekt badań nt. zastosowania IVA/VCA w zakładach karnych. Założenia koncepcyjne zostały opisane w artykule w 2015 r. Przeprowadzili analizy zarejestrowanych nagrań ze zdarzeń prób samobójczych i samobójstw oraz innych zdarzeń z udziałem osadzonych. Badali literaturę tematu oraz możliwości zastosowania istniejących rozwiązań IVA, przygotowali też nagrania symulowanych scen sytuacyjnych w celach więziennych do prac nad dedykowanym oprogramowaniem jako materiał wejściowy do opracowania analizy wizyjnej.

Koncepcja obejmowała zastosowanie IVA oraz uczenia maszynowego (Machine learning – ML). Materiały zostały przygotowane w laboratorium Centralnego Ośrodka Szkolenia SW w Kaliszu. Opracowane zostały założenia koncepcyjne do programu badawczo-rozwojowego. Koncepcja obejmuje szereg zagadnień i wykorzystuje wieloletnie doświadczenie autorów w zakresie psychologii i systemów dozoru wizyjnego.

Źródło: opracowanie własne

Źródło: opracowanie własne

Źródło: opracowanie własne

Początkowe założenia koncepcyjne objęły szerokie zastosowanie analizy wizyjnej. Poniżej przykład obszarów dozorowania, z przyporządkowanymi automatycznie alarmami generowanymi po zebraniu wystarczającego materiału behawioralnego do stworzenia maszynowego wzorca zachowań:

- W celach mieszkalnych, celi izolacyjnej, przejściowej, celi dla tzw. niebezpiecznych, celi szpitalnej, ambulatoryjnej. Alarm uruchamia się, gdy:

– osadzony nie porusza się w łóżku w określonym czasie,

– zakrywa się kołdrą, kocem,

– osadzony przebywa „długo” w kąciku sanitarnym,

– zbyt długo stoi nieruchomo przy oknie lub przy zamkniętych drzwiach,

– w celi pojawia się dynamiczny ruch,

– nastąpiło omdlenie lub upadek osadzonego,

– pojawiły się niepokojące stany emocjonalne u osadzonego. - W celi zabezpieczającej. Alarm uruchamia się, gdy:

– osadzony nie porusza się w celi w określonym czasie,

– pojawia się dynamiczny ruch w celi,

– osadzony przebywa „długo” przy zamkniętych drzwiach,

– nastąpiło omdlenie, upadek osadzonego,

– wystąpiły niepokojące stany emocjonalne u osadzonego. - W świetlicach, na placach spacerowych. Alarm uruchamia się, gdy:

– występuje dynamiczny ruch w wyznaczonej przestrzeni,

– dwóch, trzech osadzonych znajdzie się w odległości mniejszej niż dozwolona, np. 30 cm,

– pojawia się osoba, która nie powinna znajdować się w wyznaczonej przestrzeni,

– wystąpiły wyraźne sygnały napięcia emocjonalnego w grupie osadzonych. - W przejściach, wejściach, łącznikach budynków. Alarm uruchamia się, gdy:

– system identyfikacji nie rozpoznaje twarzy,

– pojawia się dynamiczny ruch w wyznaczonej przestrzeni,

– pojawią się osoby, które nie powinny w tym czasie znajdować się w wyznaczonej przestrzeni, np. grupy izolacyjne w areszcie. - Pasy ochronne, teren więzienia. Alarm uruchamia się, gdy:

– nastąpi przekroczenie wirtualnych granic lub zmiana kierunku ruchu osób,

– w polu obserwacji znajdą się pozostawione lub przerzucone przez wygrodzenia przedmioty,

– pojawią się poruszające się obiekty – drony.

Ponadto inteligentna analiza obrazów obejmowałaby obraz ścian budynków, pawilonów mieszkalnych czy innych i reagowała alarmem na nielegalne kontakty między osadzonymi, pojawienie się obiektu (np. liny, dronu) lub człowieka (np. uciekiniera). Jednak podstawowym celem wieloletnich badań i analiz prowadzonych przez autorów jest sytuacja przeciwdziałania samobójstwom, szczególnie w celach poddanych stałemu dozorowi wizyjnemu – stale obserwowanemu zachowaniu osadzonych przez funkcjonariusza, tzw. monitorowego.

Wnioski autorów o niezbędnej ostrożności wdrażania technologii analizy wizyjnej potwierdzają także wyniki badania NW Systems Group z Wielkiej Brytanii – 9 na 10 użytkowników tej technologii zgłasza zbyt dużą liczbę fałszywych alarmów przez nią generowanych. Wynika to przede wszystkim ze złej jakości wykonania, eksploatacji i konfiguracji systemów dozoru wizyjnego. Aż 27% badanych stwierdziło, że te alarmy wynikały z błędnego doboru i konfiguracji analityki wizyjnej, a 41% wskazało na owady i zabrudzenie optyki kamer4.

Istnieje niebezpieczeństwo wykorzystania medialnego wrażenia, jakie robi funkcjonowanie analizy wizyjnej do pozornego działania, mającego pomóc w przeciwdziałaniu samobójstwom, czyli wdrożenie niezbadanej i niewłaściwie skonfigurowanej technologii. Podobnie wygląda sytuacja ze szkoleniami operatorów w zakresie przeciwdziałania samobójstwom, których metodyka nie jest wypracowana. Najpierw należy opracować koncepcję, następnie zgromadzić wiedzę, aby stworzyć teorię. Kolejny etap to sprawdzenie empiryczne, czyli przeprowadzenie serii badań weryfikujących teorię. Dopiero na tej podstawie można wypracować metodykę szkolenia czy wdrażać rozwiązania tak zaawansowanych technologii. Skoro jest potrzeba, pojawiają się szkolenia, które w tytule mają operatora lub dotyczą monitoringu wizyjnego. Nie oznacza to jednak, że przygotowują one merytorycznie do realizacji zadań na tym stanowisku. Autorzy wskazują na ryzyko pochopnych i pozornych działań, zwłaszcza gdy chodzi o tak delikatną materię, jak życie ludzkie i samobójstwo.

Należy także przywołać odmienne podejście do opisanego wyżej, polegające na ograniczeniu kontroli i dozoru osadzonych. To sukces systemu penitencjarnego w Norwegii i Niemczech, który przyniósł oczekiwany efekt zmniejszenia liczby antyspołecznych zachowań i zdarzeń. Wystarczyło otoczyć osadzonych opieką, z poszanowaniem godności człowieka i humanitaryzmem.

Opisane w artykule zaawansowane prace badawczo-projektowe zostały przerwane w COSSW w Kaliszu w związku z likwidacją tej jednostki, ale są kontynuowane przez autorów w ramach własnej aktywności naukowej i publikacyjnej.

|

|

|

|

1 Seul, Sztuczna inteligencja wykrywa i zapobiega próbom samobójczym na mostach, „Rzeczpospolita”, 30.06.2021 r.

2 C. Mecwaldowski, R. Poklek, Przygotowanie stanowiska operatora systemu dozoru wizyjnego. Aspekty psychologiczne i techniczne, OMiI 6/2019.

3 J. McCormick, What AI Can Tell from Listening to You, “The Wall Street Journal”, 1.04.2019.

4 IFSEC Global: 93% of firms reporting excess of CCTV false alarms linked to poor installation or maintenance (https://www.ifsecglobal.com/author/ifsecglobal/ (dostęp: 15.08.2021)