Warsztaty z PTZ-kami – update

Jan T. Grusznic

Schyłek rozwiązań typu PTZ zaczęto wieszczyć już w chwili intensywnego rozwoju kamer wysokiej rozdzielczości wyposażonych w obiektywy szerokokątne. Miały one zastąpić urządzenia, których praca jest oparta na mechanizmach pozycjonujących. Głównymi powodami były krótsza żywotność ruchomych elementów mechanicznych w porównaniu z układami elektroniki oraz coraz większa czytelność szczegółów w obrazach z kamer hemisferycznych.

Prognoza ta się nie potwierdziła. Co więcej, nastąpiło zintensyfikowanie działań na rzecz lepszej integracji tych dwóch rozwiązań. Kamera PTZ umożliwia szybkie zbliżenia i podejrzenia szczegółów sceny nawet ze znacznych odległości, natomiast kamera wyposażona w obiektyw szerokokątny idealnie sprawdza się w oglądzie zdarzeń w pobliżu instalacji punktu kamerowego. W ślad za oczywistymi korzyściami, jakie dało połączenie tych dwóch technologii obrazowania, zaczęto eksperymentować z kolejnymi połączeniami kamer PTZ oraz termowizji lub radaru.

Kamery obrotowe mają coraz więcej funkcjonalności, więcej pamięci pozycji zaprogramowanych (presetów), szybciej się obracają, zapewniają automatyczne śledzenie oparte na coraz „mądrzejszych” algorytmach.

Pomimo galopującego postępu technologicznego i wprowadzania kolejnych innowacyjnych rozwiązań ich podstawową funkcją nadal pozostaje tworzenie użytecznych obrazów z rozległego obszaru. W każdej chwili z kadru sceny ogólnej można dojrzeć szczegóły w miejscu odległym o kilkadziesiąt lub nawet kilkaset metrów. Kojarzymy je z miejskimi ulicami, gdzie pracują na rzecz poprawy bezpieczeństwa mieszkańców, z dozoru otwartych, rozległych przestrzeni stref produkcyjnych i lotnisk. Czasami stanowią dopełnienie systemu, a czasem jego podstawę. Niezależnie od miejsca instalacji ich misją jest pokrycie rozległego terenu wokół punktu obserwacji.

Praca kamery PTZ jest oparta na mechanizmie obrotowym, który jest połączony z modułem optycznym wyposażonym w obiektyw typu motozoom z automatyką ustawiania ostrości (autofokus – AF). To właśnie ostatnia właściwość – autofokus – sprawia, że te rozwiązania wdarły się przebojem do większości instalacji systemów dozoru wizyjnego. We wcześniejszych (i cały czas dostępnych, lecz rzadziej już używanych) rozwiązaniach z niezależną kamerą, obiektywem ze zdalną regulacją ogniskowych oraz głowicą uchylno-obrotową brak automatycznego ustawiania ostrości często wymuszał interwencję człowieka w celu ustawienia pożądanej jakości obrazu. Stąd być może zakorzeniło się przekonanie, że za każdą kamerą stoi człowiek. Sterowanie kamerami na ogół przypisuje się przeszkolonym operatorom, którzy korzystają z nich na co dzień w miejskich lub gminnych systemach monitoringu.

W przypadku zakładów przemysłowych sterowanie jest współdzielone między załogę zabezpieczającą obiekt, automatykę zakładu oraz analizę obrazu, a celem jest takie rozwiązanie, które zapewni ciągły nadzór procesów, nie angażując zanadto pracowników ochrony. Wykorzystuje się zaprogramowane pozycje, nagrane trasy, automatykę śledzenia w obszarach o niskim poziomie aktywności, wybrane algorytmy analizy obrazu [1] dla poszczególnych punktów dozoru oraz coraz bardziej złożoną integrację z urządzeniami zewnętrznymi.

AF – jak to naprawdę działa?

Zadaniem kamer PTZ jest szybkie dostarczenie czytelnego obrazu ze zbliżenia optycznego, dlatego niezwykle ważne jest jak najszybsze uzyskanie ostrości. Odpowiada za to mechanizm automatycznego ostrzenia, czyli autofokus (AF). Układy AF wykorzystywane w modułach optycznych kamer PTZ mierzą poziom kontrastu na przetworniku obrazu (tryb pasywny). Metoda ta polega na wykrywaniu różnic w naświetleniu sąsiadujących grup pikseli obrazu poprzez analizę światła na matrycy światłoczułej. Gdy obraz nie jest ostry, przejścia między pikselami są łagodne i różnice w kontraście niewielkie. Im kontrast jest wyższy, tym większa ostrość obrazu. Pomiar następuje w określonym, wybranym polu autofokusa. W niektórych kamerach PTZ można wskazać obszar kadru, który ma być analizowany do pomiaru poziomu kontrastu.

Co ważne, metoda detekcji kontrastu nie wymaga skomplikowanych mechanizmów pomiarowych. Jest bardzo dokładna (kluczowy jest tu odpowiedni algorytm), jeżeli w polu AF znajdują się zróżnicowane motywy, a nie gładka powierzchnia (to sprawia problem każdej pasywnej metodzie AF).

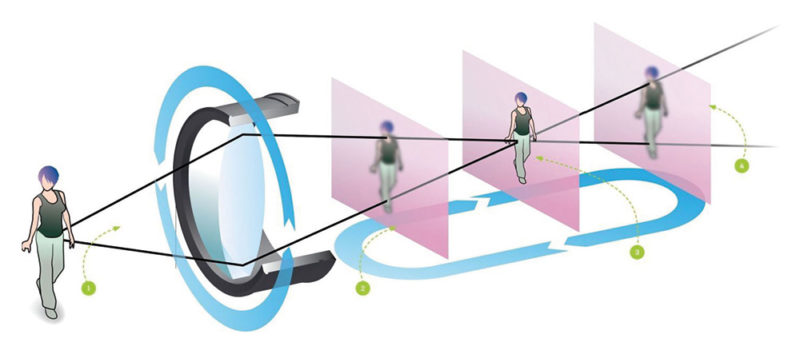

1. Zmiana sceny. Układ soczewek zaczyna się przemieszczać do tyłu (w tym przypadku).

2. Obraz nieostry o słabym kontraście. Soczewki są przemieszczane dalej w celu określenia punktu dla wyższego kontrastu.

3. Obraz ostry. Pomimo odnalezienia punktu ustawienia soczewek dających obraz o najwyższym kontraście soczewki są przesuwane dalej, aby sprawdzić, czy jest miejsce, w którym poziom kontrastu może być jeszcze wyższy.

4. Obraz nieostry o słabym kontraście – po przejechaniu punktu ostrości kontrast spada. Układ ustawia soczewki w miejscu, dla którego odnotowano najwyższy kontrast.

Sposób działania opisanego rozwiązania przedstawiono na rys. 1. W większości przypadków kamera „zgaduje”, w którym kierunku ma przesunąć soczewki obiektywu, by kontrast się zwiększył. Jeśli wybiera zły kierunek, kontrast zaczyna się zmniejszać i operacja się wydłuża. Soczewki są przesuwane z powrotem, już w kierunku prawidłowym. Ale na tym nie koniec, skąd bowiem automat ma wiedzieć, że osiągnięto maksymalny kontrast? Przesuwa soczewki dalej, aż kontrast znów zacznie się zmniejszać i dopiero wówczas zawraca. Jak widać, proces ogniskowania chwilę trwa – soczewki w obiektywie przemieszczają się raz w jedną, raz w drugą stronę. Taka metoda prób i błędów prowadzi czasem do zjawiska zwanego focus hunting (efekt pulsowania), które objawia się „pompowaniem” obrazu podczas prób zogniskowania.

Focus hunting pojawia się w przypadku obserwacji scen słabo oświetlonych, a co za tym idzie o niskim współczynniku kontrastu. Problem przybiera na sile, gdy dodatkowo kamera obserwuje scenę o silnym oświetleniu skierowanym w jej stronę (np. światła z reflektorów samochodów lub oświetlenie wnętrza hali docierające przez otwartą bramę podczas nocnej obserwacji). Bardzo często w takich scenariuszach kamera niepoprawnie ustawia ostrość, koncentrując się na błędnym odczycie kontrastu, który jest spowodowany wewnętrznymi odbiciami promieni wewnątrz obiektywu. W efekcie obraz jest mocno rozogniskowany, a punkty świetlne tworzą tzw. efekt bokeh2.

Producenci kamer PTZ opisane ograniczenia pasywnej metody ustawiania ostrości rozwiązują wielorako. Pierwszym i najczęstszym sposobem jest zapamiętanie pozycji soczewki skupiającej (ostrości) przy zapamiętywaniu prepozycji. W momencie zapisywania presetu do pamięci kamery zapisywane są, oprócz jego numeru i nazwy, różne zmienne, takie jak pozycja ogniskowej, pozycja wychylenia, pozycja obrotu, pozycja soczewki ogniskującej (fokus, czyli ostrość), a czasami nawet pozycja zamknięcia przysłony (w przypadku stosowania silnika krokowego). Gdy informacja o presecie została zapisana dla sceny kontrastowej, wtedy przywołanie presetu będzie gwarantowało uzyskanie ostrości bez efektu pulsowania (focus hunting) nawet w warunkach słabego oświetlenia, ponieważ pozycja soczewek skupiających będzie przywołana z bazy danych kamery. Trasa dozorowa zawierająca tak zaprogramowane pozycje będzie gwarantowała utrzymanie ostrości przez cały czas.

Drugim sposobem jest wykorzystanie stref ostrości. Jest to rozwiązanie podobne do zapamiętywania ostrości dla konkretnej prepozycji z tą różnicą, że wartość ustawienia soczewek skupiających jest podawana dla większego obszaru. Technicznie przypomina to tworzenie wirtualnej maski (trochę jak maski prywatności) dla kamery PTZ, która jest powiązana z koordynatami P/T (zakres pochylenia i obrotu), a czasami również z krotnością przybliżenia. W momencie, gdy kamera podczas wykonywania patrolu – trasy nagranej przez użytkownika – wchodzi w zakres koordynat P/T związanych ze strefą ostrości, automatyczny system ostrzenia przełącza się na wartości ustawienia soczewek skupiających dla tej strefy. Po wyjściu kamery ze strefy ostrości system AF jest załączany ponownie. Dzięki temu można utrzymać ostrość obrazu przy ciągłym patrolowaniu obszaru nawet dla tras zaprogramowanych przez operatora.

Trzecim rozwiązaniem jest wykorzystanie technik doświetlenia sceny zwiększających kontrast lub pomiaru odległości. Zasada pomiaru odległości opiera się na technice wykorzystywanej przez profesjonalne przyrządy pomiarowe stosowane w budownictwie. Czujnik laserowy zawiera diodę laserową, której zadanie sprowadza się do wyświetlania plamki promienia lasera na powierzchni mierzonego obiektu. Światło odbite od widzialnej plamki zostaje zobrazowane za pomocą obiektu światłoczułego. Obecnie można dokonywać pomiaru odległości z dokładnością do kilkunastu milimetrów metodą time-of-flight (ToF), wykorzystującą pulsującą wiązkę światła lasera, która jest emitowana przez czujnik i ulega odbiciu od obiektu. Odległość do obiektu określa się na podstawie pomiaru czasu upływającego od emisji wiązki do jej powrotu do czujnika po odbiciu. W ten sposób układ optyczny bazuje na bezwzględnych wartościach dostarczanych przez układ pomiarowy, utrzymując ostrość za każdym razem bez konieczności sprawdzania poziomu kontrastu na przetworniku.

W przypadku wykorzystania laserowych systemów pomiarowych należy pamiętać, że skoncentrowana wiązka laserowa może spowodować trwały uszczerbek na zdrowiu, jeśli energia emitera jest zbyt duża. Dlatego też w laserowych urządzeniach pomiarowych rzadko spotyka się klasę powyżej 1 (zgodnie z IEC 60825-1) lub 1M. Ogranicza to ich zasięg do ok. 100 m. Lasery tych klas są bezpieczne w racjonalnych warunkach pracy. Klasa 1M może być potencjalnie niebezpieczna, ale tylko w momencie obserwowania wiązki przez przyrządy optyczne.

Oświetlenie a bezpieczeństwo fotobiologiczne

Coraz powszechniejsze, trwalsze i wydajniejsze systemy oświetlenia podczerwienią integrowane w kamerach stałopozycyjnych doczekały się też pełnej integracji z kamerami PTZ. Pełnej, bowiem obecnie wbudowane oświetlacze w pełni współgrają z krotnością zoomu, zawężając kąt świecenia adekwatnie do kąta obserwacji. Dzięki temu są w stanie uzyskiwać akceptowalny poziom kontrastu w scenie odległej o 200 lub nawet 500 m od punktu kamerowego. Tak duże zasięgi wymagają sporej energii źródeł promieniowania, co przekłada się na zwiększenie zagrożenia fotobiologicznego. Oczywiście nie wszystkie źródła promieniowania są w takim samym stopniu potencjalnym zagrożeniem zdrowia, dlatego należało ustalić kryteria zagrożenia fotobiologicznego promieniowaniem optycznym emitowanym przez emitery stosowane w urządzeniach m.in. do dozoru wizyjnego.

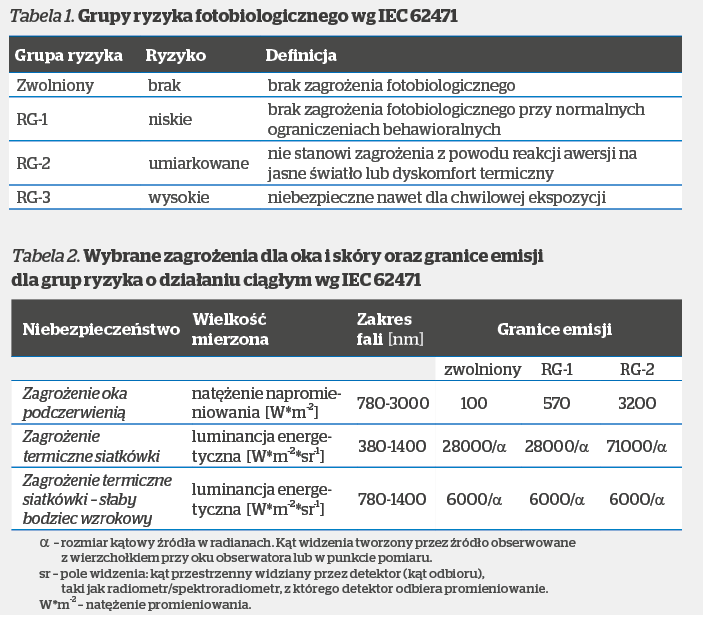

W tym celu została opracowana norma IEC 62471 (Bezpieczeństwo fotobiologiczne lamp i systemów lampowych), w której podano klasyfikację źródeł promieniowania (z wykluczeniem laserów) ze względu na bezpieczeństwo fotobiologiczne. Klasyfikacja ta opiera się na maksymalnych dopuszczalnych ekspozycjach (MDE) w całym zakresie promieniowania emitowanego przez dane źródło. Uwzględniono w niej poziom promieniowania emitowanego przez dane urządzenie (lampę lub system lampowy), zakres widmowy promieniowania i dostęp człowieka. W każdej grupie ryzyka ustalono kryteria czasowe dla każdego zagrożenia fotobiologicznego. Kryteria dobrano tak, aby stosowana wartość graniczna nie została przekroczona w danym czasie.

Zgodnie z IEC 62471 źródła promieniowania optycznego są klasyfikowane do grup ryzyka z zastrzeżeniem ich potencjalnego zagrożenia fotobiologicznego. Klasyfikacja jest oparta na ocenie ryzyka, którą przeprowadza się na poszczególnych składnikach lub produkcie końcowym na podstawie informacji uzyskanych od producenta. Źródła dzieli się na cztery grupy wg zagrożenia (tab. 1), wg limitu emisji oraz dopuszczalnego czasu ekspozycji przed przekroczeniem zagrożenia.

Istnieją różne zagrożenia biologiczne, które są rozpatrywane w różnych zakresach długości fal zgodnie z normą IEC 62471. Uwzględnia się biologiczny wpływ na oczy i skórę. W tabeli 2 przedstawiono wybrane zagrożenia wynikające z zakresu długości fali pracy promienników stosowanych w dozorze wizyjnym.

Istnieją różne zagrożenia biologiczne, które są rozpatrywane w różnych zakresach długości fal zgodnie z normą IEC 62471. Uwzględnia się biologiczny wpływ na oczy i skórę. W tabeli 2 przedstawiono wybrane zagrożenia wynikające z zakresu długości fali pracy promienników stosowanych w dozorze wizyjnym.

Na potrzeby normy zdecydowano, że odległości, przy których podaje się wartości zagrożeń fotobiologicznych spowodowanych promieniowaniem lamp, powinny wynosić 200 mm dla wszystkich innych źródeł światła niż lampy stosowane w oświetleniu ogólnym.

I tak:

- lampy IR nie stwarzają żadnego zagrożenia fotobiologicznego, jeżeli nie ma ryzyka zagrożenia termicznego siatkówki w ciągu 10 s ani zagrożenia oka napromieniowaniem podczerwonym w ciągu 1000 s. Również emitery, które generują promieniowanie IR bez silnego bodźca wizualnego (czyli mniej niż 10 cd/m2) i nie stwarzają zagrożenia dla siatkówki bliską IR w czasie 1000 s ekspozycji, są zaliczane do grupy wolnej od ryzyka;

- promienniki IR sklasyfikowane do RG-1 nie stwarzają zagrożenia z powodu normalnych ograniczeń ekspozycji w warunkach użytkowania. Wymaganie to jest spełnione przez każdy emiter, który przekracza granice grupy wolnej od ryzyka, ale nie stwarza zagrożenia termicznego dla siatkówki w czasie 10 s ani zagrożenia dla oka promieniowaniem IR w czasie 100 s;

- promienniki IR sklasyfikowane jako RG-2 nie stwarzają zagrożenia z powodu dyskomfortu termicznego. Wymaganie to spełnia każdy promiennik, który przekracza granice grupy RG-1, ale nie stwarza zagrożenia termicznego dla siatkówki w czasie 250 ms ani zagrożenia dla oka promieniowaniem IR w czasie 10 s;

- wszystkie promienniki sklasyfikowane jako RG-3 mogą stwarzać zagrożenie nawet przy chwilowej lub krótkiej ekspozycji i są zaliczane do grupy wysokiego ryzyka.

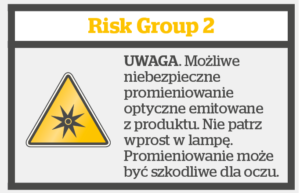

Jest mało prawdopodobne, aby emitery wykorzystywane w kamerach PTZ były klasyfikowane jako RG-3. Niemniej warto sprawdzić, do jakiej grupy producent je zaklasyfikował. Natomiast promienniki dużej mocy, które są w stanie oświetlić scenę z odległości 500 m, są na ogół klasyfikowane jako RG-2. Na rys. 2 przedstawiono przykładową etykietę, jaka powinna się znajdować na urządzeniu klasyfikowanym wg IEC 62471 dla RG-2.

Ułomnością rozwiązania – kamery PTZ zintegrowanej z wysokoenergetycznym oświetlaczem IR – jest wygrzewanie całego układu kamery, w tym również przetwornika obrazu. Wpływa to na jakość obrazu w postaci widocznego szumu, który nie zależy od liczby fotonów padających na powierzchnię światłoczułą. Szum związany z temperaturą przetwornika CMOS ma charakter losowy i w każdej klatce inny rozkład przestrzenny. Nie ma prostej możliwości usunięcia szumu, jedynie można go uśrednić np. metodą filtracji dolnoprzepustowej, tracąc jednak część informacji. Drugą możliwością (ograniczoną do statycznych ujęć) jest wykonanie serii zdjęć i ich uśrednienie. Niedoskonałości obrazu stają się bardziej widoczne wraz ze wzrostem jego rozdzielczości. Oznacza to, że oprócz rozwiązania problemu z szybkim chwytaniem ostrości również szybkie odprowadzanie ciepła z układu, a przede wszystkim odseparowania go od obszaru instalacji układu CMOS staje się polem innowacyjnych rozwiązań inżynieryjnych pozwalających utrzymać wysoką jakość obrazu.

Kopułka – okno na świat

Niezmiennie od wielu lat stałym elementem znacznej liczby kamer PTZ obecnych na rynku jest kopułka, która może być wykonana z poliwęglanu (często spotykane rozwiązania wandaloodporne), akrylu (o mniejszej odporności na udary mechaniczne) lub nylonu (większa elastyczność). Każdy z wymienionych materiałów ma istotne właściwości optyczne, niepozostające bez wpływu na jakość uzyskanego obrazu. Kopuły poliwęglanowe mają stosunkowo grube ścianki, co w przypadku długich ogniskowych może stwarzać problem z uzyskaniem odpowiedniego poziomu ostrości, niewidoczny przy ujęciach o szerokim kącie. Choć kopuły poliwęglanowe cieszą się największym zainteresowaniem, są zastępowane przez akryl charakteryzujący się lepszymi właściwościami optycznymi.

Wbrew obiegowej opinii kopułki akrylowe nie są przeznaczone tylko do zastosowań wewnątrz budynków, spełniają swoje zadanie również w instalacjach zewnętrznych. Ich odporność na uderzenia nie przekracza 5 dżuli (IK08), co najczęściej jest wystarczające. Nylon, mało popularny materiał ze względu na skomplikowany proces wytwarzania, jest głównie stosowany w hermetycznych rozwiązaniach ciśnieniowych. Właściwości optyczne kopułek nylonowych można porównać z akrylem, choć z widoczną różnicą na korzyść tego drugiego.

Wielkość kopułek, ich osadzenie i montaż stanowi nieraz proces żmudnych obliczeń, aby znaleźć idealne dopasowanie. Dlaczego jest to tak istotne, pokazuje przykład obserwacji otoczenia za oknem. Gdy obserwujemy scenę na zewnątrz naszego domu lub biura (patrząc prostopadle przez szybę), jakość obrazu jest bardzo dobra. Gdy jednak zaczynamy obserwować scenę odległą, znajdującą się bardziej pod kątem, okazuje się, że płaska szyba obniża jakość widzenia i pogarsza skuteczność obserwacji. Wyobraź sobie, że wykonujesz tę samą obserwację, ale tym razem korzystasz z lornetki z 30-krotnym zbliżeniem. Problem przybiera na sile. Ten sam przypadek występuje w kamerach PTZ – nie we wszystkich, rzecz jasna, ale zdarza się, że obraz staje się znacznie lepszy po zdjęciu kopułki.

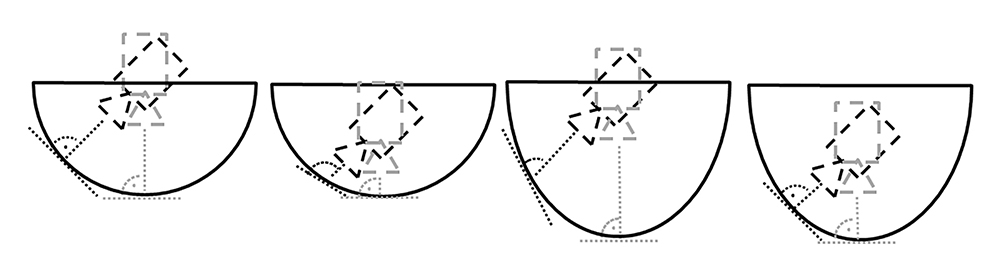

Kopuła sama w sobie nie musi stanowić problemu. Na rys. 3a i rys. 3d pokazano dwie różne krzywizny dające dobre rezultaty pomimo różnej konstrukcji kopuł. Z kolei na rys. 3b widać, jak przy idealnej krzywiźnie kopuły zbyt niskie osadzenie modułu optycznego wymusi w wybranych pozycjach modułu obserwację „pod kątem” do powierzchni kopuły – w konsekwencji spowoduje to problem braku ostrości przy znacznych zbliżeniach. Ale niższe osadzenie ma też plusy. Po pierwsze umożliwia obserwację nieco powyżej linii horyzontu (180°+), co jest korzystne w dozorze na dalekie odległości lub „pod górę”. Po drugie zmniejsza dystans między wewnętrzną stroną kopułki a modułem, dzięki czemu mniejsza ilość promieniowania odbitego od wewnętrznej sfery kopuły trafia do oka kamery. Umieszczenie elementu optycznego wyżej (rys. 3c) spowoduje powstanie dużej liczby odbić i utrudni obserwację w nocy, gdy kamera jest zamocowana np. pod latarnią uliczną lub gdy zza kamery pada silne światło. Nie bez powodu zatem producenci wyposażają moduł optyczny w wiele czarnych, otaczających elementów z tworzywa, ograniczając w ten sposób liczbę powstałych wewnątrz refleksów.

Kopułka powinna być regularnie czyszczona, a w przypadku widocznych zadrapań i uszkodzeń – wymieniona. W przeciwnym razie kurz, brud, promienie odbijające się w powstałych mikrouszkodzeniach będą pogarszały właściwości optyczne, a w efekcie obniżały jakość rejestrowanego materiału. A jeśli kamera nie ma kopułki? Coraz więcej kamer ma budowę „odkrytą” – tylko optyka znajduje się za płaską szybą o zwiększonej odporności na udary mechaniczne. Reszta jest „dostępna”, co oznacza, że jest narażona na mechaniczną zmianę pozycji kamery lub wnikanie brudu zatykającego otwory wentylacyjne. W obu przypadkach warto sprawdzić, czy i w jaki sposób kamera powiadomi system lub operatora o wymuszonej zmianie pozycji oraz jak czyścić kamerę z nagromadzonego pyłu.

Czułość – dlaczego ślepnę?

Brak dokumentów normatywnych pomiarów czułości kamer doprowadził do pewnej dowolności badań i interpretacji wyników pomiarów. Tymczasem wartości pozbawione wspólnego mianownika, podawane przez producentów kamer PTZ, są trudne do porównania. Nie oznacza to, że są bezużyteczne.

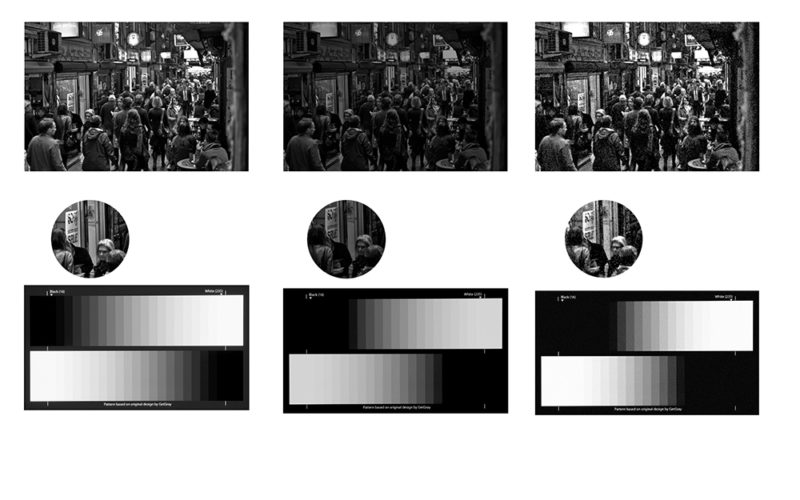

Wartość czułości kamer zależy od wielu czynników, w tym m.in. od poziomu wzmocnienia wykorzystywanego przy pomiarze apertury obiektywu f, poziomu odbicia przedmiotu (sceny), na który było skierowane oświetlenie, czy temperatury barwowej (stopnie Kelvina) oświetlenia użytego podczas pomiaru. Odpowiednia modyfikacja parametrów zapewnia uzyskanie „lepszych” wyników umieszczanych w kartach katalogowych [2]. Tymczasem jakość obrazu oceniamy subiektywnie wg wierności odtworzenia kolorów, skali szarości, czy mówiąc oględnie, po czytelności szczegółów w obrazie. Im skala odwzorowania jest szersza, tym wierniejsze odwzorowanie (rys. 4a). Przy mniejszym zakresie skali (rys. 4b) niektóre elementy są przedstawiane niepoprawnie (np. białe płaszczyzny), a detale są niewidoczne – jakość obrazu ubożeje.

AGC wyłączone (lub wzmocnienie na poziomie 0 dB)

Rys. 4b. Obraz reprezentujący scenę o niższym poziomie oświetlenia,

gdzie reprodukcja szarości kończy się w połowie gamy szarości tablicy testowej,

AGC wyłączone (lub wzmocnienie na poziomie 0 dB)

Rys. 4c. Obraz reprezentujący obraz ze sceny 4b przy uruchomionej automatyce

wzmocnienia AGC do poziomu uzyskania poziomu bieli

Niestety wartości czułości kamer są „poprawiane” poprzez zwiększanie poziomu wzmocnienia sygnału, aż do wartości zmieniających obraz, utrudniający obserwację szczegółów. AGC (ARW – automatyczna regulacja wzmocnienia) jest rozwiązaniem wzmacniającym sygnał, który optycznie rozjaśnia obraz (rys. 2c). Takie rozjaśnienie tylko pozornie tworzy go subiektywnie lepszym. Detale są mniej wyraźne, o niższej rozdzielczości. Dlatego zasadne jest, aby poziom wzmocnienia podczas pomiarów był ustawiany na 0 dB, a wartość pomiaru była odnotowywana dla najgorszego przypadku, gdy poziom bieli jest jeszcze widoczny na tablicy testowej. Nie jest to jednak zapis normatywny, a wyłącznie zdrowy rozsądek.

Ponieważ porównywanie czułości kamer prowadzi na manowce (podaną wartość i tak trudno zweryfikować ze względu na wskazany brak norm pomiarowych), odwróćmy pytanie – jaki powinien być poziom oświetlenia sceny Escena, aby obraz był użyteczny? Odpowiedź na to pytanie nie jest trudna, o ile znamy:

- wartość czułości kamery Eprzetwornik

- poziom odbicia światła od sceny (odbiciowość sceny Rscena)

- aperturę obiektywu f

- współczynnik przepuszczalności soczewek obiektywu (% zdolność przepuszczalności światła) t

- współczynnik odbicia światła od soczewek obiektywu (% poziom odbicia światła od soczewek) Robiektyw

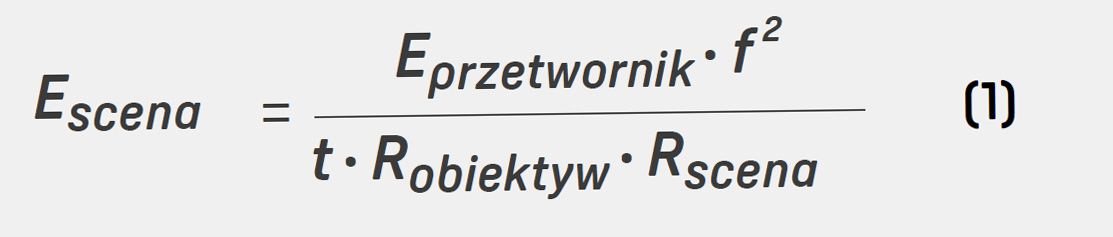

Zależność powyższych parametrów jest opisana wzorem:

Uzyskanie informacji o wartości czułości kamery oraz wartości przysłony, przy jakiej wykonano pomiar, nie nastręcza problemu, ponieważ znajdziemy je w kartach katalogowych każdego szanującego się producenta. Pozostałe wartości często wiążą się z dostępem do badań z pomiarów, które nie są prezentowane publicznie. Dlatego trzeba przyjąć pewne założenia:

Uzyskanie informacji o wartości czułości kamery oraz wartości przysłony, przy jakiej wykonano pomiar, nie nastręcza problemu, ponieważ znajdziemy je w kartach katalogowych każdego szanującego się producenta. Pozostałe wartości często wiążą się z dostępem do badań z pomiarów, które nie są prezentowane publicznie. Dlatego trzeba przyjąć pewne założenia:

t = 0,7 (70%)

Robiektyw = 0,8 (80%)

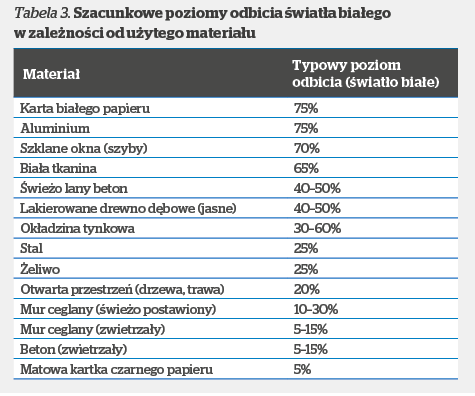

Powyższe wartości odpowiadają przyjęciu najgorszego scenariusza, ponieważ dostęp do tych parametrów jest ograniczony (aby nie uznać za niemożliwy). Poziom odbicia sceny Rscena będzie się różnił w zależności od tego, co obserwujemy. W tabeli 3 zaprezentowano przykładowe, przybliżone poziomy odbicia promieniowania światła białego [3].

By uprosić sprawę profesjonalnym fotografom, na początku lat 50. XX wieku firma Kodak [4], chcąc wskazać poprawną procedurę pomiaru poziomu światła w scenie, sugerowała, aby wykonywać go z użyciem szarej karty Kodaka, co zapewni właściwe naświetlenie błony światłoczułej. Szara karta Kodaka powstała w trakcie długich badań pracowników laboratorium firmy, gdzie wykazano, że średni poziom odbicia otaczających nas przedmiotów wynosi ok. 20% (dokładnie 18%). Do dziś wszelkie urządzenia pomiarowe do ustalenia poziomu światła odbitego są kalibrowane zgodnie z zasadą przyjętą w latach 50. ub. wieku (światłomierze w cyfrowych apartach fotograficznych zgodnych z ANSI są kalibrowane z 12% poziomem odbicia) [5]. A jeśli tak, to i do naszego równania wstawimy wartość Rscena = 0,18 (18%). W ten sposób mamy już wszystkie zmienne potrzebne do równania.

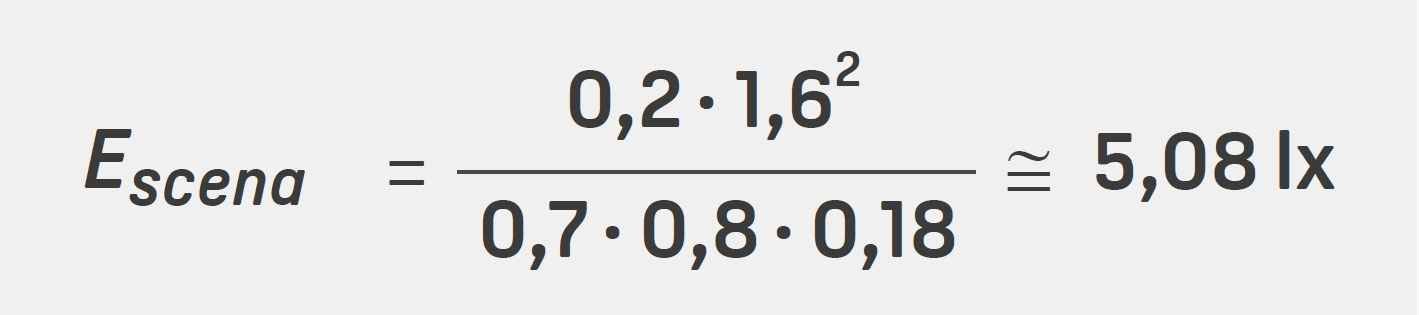

Zatem przy założeniu, że kamera ma czułość 0,2 lx w trybie kolorowym dla przysłony f/1.6, to podstawiając te wartości do wzoru (1), otrzymamy wymagany poziom oświetlenia sceny:

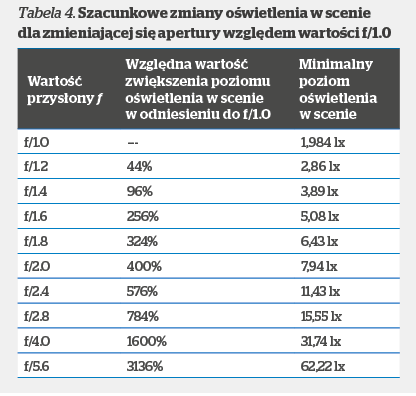

Dlaczego zatem przy poziomie około 5 lx w momencie zbliżenia obraz staje się bardziej zaszumiony, a szczegóły mniej czytelne? Powodem jest przyjęty standard podawania wartości czułości dla najniższej wartości przysłony f. Tymczasem ten parametr w modułach optycznych kamer PTZ zmienia się w całym zakresie ogniskowych, np. zakres 4–100 mm f/1.6–4.0 oznacza, że dla ogniskowej 4 mm najmniejsza wartość przysłony to f/1.6, a dla 100 mm najmniejsza wartość przysłony to f/4.0. Jest to istotne, ponieważ ilość światła przechodzącego przez przysłonę zmniejsza się wraz ze wzrostem wartości przysłony zgodnie z tab. 4.

Dlaczego zatem przy poziomie około 5 lx w momencie zbliżenia obraz staje się bardziej zaszumiony, a szczegóły mniej czytelne? Powodem jest przyjęty standard podawania wartości czułości dla najniższej wartości przysłony f. Tymczasem ten parametr w modułach optycznych kamer PTZ zmienia się w całym zakresie ogniskowych, np. zakres 4–100 mm f/1.6–4.0 oznacza, że dla ogniskowej 4 mm najmniejsza wartość przysłony to f/1.6, a dla 100 mm najmniejsza wartość przysłony to f/4.0. Jest to istotne, ponieważ ilość światła przechodzącego przez przysłonę zmniejsza się wraz ze wzrostem wartości przysłony zgodnie z tab. 4.

Ilość światła w scenie, jaką wyliczyliśmy, dotyczyła najszerszego kąta obserwacji. W przypadku jego zawężenia okaże się, że dla przysłony f/4.0 wymagany poziom oświetlenia w scenie wynosi min 31,74 lx.

Należy w tym miejscu przypomnieć o przyjętych założeniach i braku wiedzy co do poziomu wzmocnienia w momencie pomiaru poziomu czułości kamery przez producenta. Wyniki pochodzące z powyższych wyliczeń mają zatem charakter jedynie orientacyjny. Są jednak pomocne w określeniu rzędu wielkości minimalnego poziomu oświetlenia sceny.

Należy w tym miejscu przypomnieć o przyjętych założeniach i braku wiedzy co do poziomu wzmocnienia w momencie pomiaru poziomu czułości kamery przez producenta. Wyniki pochodzące z powyższych wyliczeń mają zatem charakter jedynie orientacyjny. Są jednak pomocne w określeniu rzędu wielkości minimalnego poziomu oświetlenia sceny.

Integracja na zakończenie

Kamery PTZ to rozwiązanie bardzo popularne wśród sprzedawców i wygodne dla projektantów systemów chcących osiągnąć szybki efekt niewielkim kosztem: • jedna kamera, która obserwuje bardzo duże przestrzenie, mająca mnóstwo zalet • jeden punkt kamerowy, jeden słup, jedno doprowadzenie zasilania i medium transmisyjnego. Co więcej, do dozoru rozległej przestrzeni jest wymagana tylko jedna licencja na oprogramowanie zapisu. Kamery PTZ zyskują przewagę dzięki wielokrotnemu zbliżeniu optycznemu, które umożliwia rozpoznanie osoby z odległości ponad 370 m (zbliżenie 30x) i w takim przypadku są trudne do zastąpienia.

Cały czas jednak pozostaje trudność w jednoczesnej obserwacji ogółu i detali za pomocą kamer PTZ. Problem znany od dawna znalazł rozstrzygnięcie stosunkowo niedawno. Producenci kamer zdecydowali się wprowadzić do oferty rozwiązanie uzupełniające w postaci dodatkowych kamer stałopozycyjnych instalowanych dokoła jednostki PTZ lub kamery hemisferycznej. Jest ono dostępne w postaci dodatkowego modułu dokładanego do kamery PTZ lub już w wersji zintegrowanej, a rolą takiego zestawu jest niezależny dozór najbliższej przestrzeni wokół punktu kamerowego.

Za pomocą dodatkowego modułu można sterować kamerą PTZ z poziomu obrazu z kamery (bądź jeśli jest ich więcej, obrazów z kamer) stałopozycyjnej oraz oznaczać na nim pozycję kamery szybkoobrotowej. Coraz powszechniejsza staje się również integracja z modułami termowizyjnymi i radarami zapewniająca lepszą automatyzację zadań.

1) Autor wraca do tematu podjętego na łamach „Systemów Alarmowych” (SA nr 6/2014), poruszając kilka nowych wątków.

2) W fotografii sposób oddawania nieostrości obiektów znajdujących się poza głębią ostrości. W Internecie są dostępne wizualizualizacje tego efektu.

Literatura [1] VCA, Wyd. specjalne „SA” (2014 r.). [2] Przykład „kreatywnego przeliczania” czułości przedstawiono w artykule nt. kamer dualnych vs. dzień/noc (cz. 1) dostępnym na sa-portal.pl. [3] Na podstawie The complete guide to cctv lighting firmy RayTec. [4] „Copying” (Kodak Publication No. M-1) (5th Ed.), Eastman Kodak Company, Published by Eastman Kodak Company, Rochester, NY, 1956. [5] http://www.bythom.com/graycards.htm

Jan T. Grusznic

Z branżą wizyjnych systemów zabezpieczeń związany od 2004 r. Ma bogate doświadczenie w zakresie projektowania i wdrażania rozwiązań dozoru wizyjnego w aplikacjach o rozproszonej strukturze i skomplikowanej dystrybucji sygnałów. Ceniony diagnosta zintegrowanych systemów wspomagających bezpieczeństwo